ภูมิหลังทางประวัติศาสตร์ของตัวประมวลผลร่วม

ในสาขาคอมพิวเตอร์แบบดั้งเดิม โปรเซสเซอร์ร่วมคือหน่วยประมวลผลที่รับผิดชอบในการจัดการสิ่งที่ซับซ้อนอื่นๆ สำหรับสมองของ CPU การประมวลผลร่วมเป็นเรื่องปกติมากในด้านคอมพิวเตอร์ ตัวอย่างเช่น Apple เปิดตัวโปรเซสเซอร์ร่วม M7 Motion ในปี 2013 ซึ่งปรับปรุงความไวในการเคลื่อนไหวของอุปกรณ์อัจฉริยะอย่างมาก GPU ที่รู้จักกันดีคือโปรเซสเซอร์ร่วมที่เสนอโดย Nvidia ในปี 2550 ซึ่งมีหน้าที่รับผิดชอบในการจัดการงานต่างๆ เช่น การเรนเดอร์กราฟิกสำหรับ CPU GPU เร่งความเร็วแอปพลิเคชันที่ทำงานบน CPU โดยการลดภาระบางส่วนของโค้ดที่เน้นการประมวลผลและใช้เวลานาน ซึ่งเป็นสถาปัตยกรรมที่เรียกว่าการประมวลผล ต่างกัน/ไฮบริด

โปรเซสเซอร์ร่วมสามารถถ่ายโค้ดที่ซับซ้อนบางส่วนด้วยข้อกำหนดด้านประสิทธิภาพเดียวหรือข้อกำหนดด้านประสิทธิภาพที่สูงมาก ทำให้ CPU สามารถรองรับชิ้นส่วนที่ยืดหยุ่นและเปลี่ยนแปลงได้มากขึ้น

บนเครือข่าย Ethereum มีปัญหาสองประการที่ขัดขวางการพัฒนาแอปพลิเคชันอย่างจริงจัง:

เนื่องจากการดำเนินการต้องใช้ค่าธรรมเนียม Gas สูง การโอนแบบธรรมดาจึงมีการกำหนดฮาร์ดโค้ดไว้ที่ 21,000 Gas Limit ซึ่งจะแสดงบรรทัดล่างสุดของค่าธรรมเนียม Gas ของเครือข่าย Ethereum การดำเนินการอื่น ๆ รวมถึงพื้นที่จัดเก็บจะทำให้ใช้ Gas มากขึ้น ซึ่งจะจำกัดการใช้งานแบบออนไลน์ ในแง่ของขอบเขตการพัฒนา รหัสสัญญาส่วนใหญ่จะเขียนขึ้นเฉพาะเกี่ยวกับการดำเนินงานด้านสินทรัพย์เท่านั้น เมื่อเกี่ยวข้องกับการดำเนินงานที่ซับซ้อนแล้ว จะต้องมีการใช้ Gas จำนวนมาก ซึ่งเป็นอุปสรรคร้ายแรงต่อ การยอมรับในวงกว้าง ของแอปพลิเคชันและผู้ใช้

เนื่องจากสัญญาอัจฉริยะมีอยู่ในเครื่องเสมือน สัญญาอัจฉริยะจึงสามารถเข้าถึงข้อมูลของบล็อกล่าสุดได้เพียง 256 บล็อก โดยเฉพาะอย่างยิ่งในการอัปเกรด Pectra ในปีหน้าและการเปิดตัวข้อเสนอ EIP-4444 โหนดแบบเต็มจะไม่เก็บข้อมูลในอดีตอีกต่อไป การบล็อกข้อมูล จากนั้นการขาดข้อมูลทำให้เกิดความล่าช้าในการเกิดขึ้นของแอปพลิเคชันที่เป็นนวัตกรรมใหม่โดยอาศัยข้อมูล ท้ายที่สุดแล้ว แอปพลิเคชัน defi เช่น Tiktok, Instagram, หลายข้อมูล, LLM ฯลฯ ล้วนสร้างขึ้นจากข้อมูล นี่คือเหตุผลที่ Lens ขึ้นอยู่กับ เหตุผลที่ Data Social Protocol จะเปิดตัว Layer 3 Momoka ก็เพราะเราคิดว่า blockchain เป็นการไหลของข้อมูลที่ราบรื่นมาก ท้ายที่สุดแล้ว chain นั้นเปิดกว้างและโปร่งใส แต่ในความเป็นจริงนี่ไม่ใช่ กรณีเพียงว่าข้อมูลสินทรัพย์โทเค็นไหลได้อย่างราบรื่น แต่สินทรัพย์ข้อมูล เนื่องจากโครงสร้างพื้นฐานพื้นฐานยังคงเป็นอุปสรรคใหญ่ มันจะจำกัดการเกิดขึ้นของผลิตภัณฑ์ Mass Adoption อย่างรุนแรง

จากข้อเท็จจริงนี้ เราพบว่าทั้งการคำนวณและข้อมูลเป็นเหตุผลที่จำกัดการเกิดขึ้นของกระบวนทัศน์การประมวลผลใหม่ Mass Adoption อย่างไรก็ตาม นี่เป็นข้อบกพร่องของบล็อกเชน Ethereum เอง และไม่ได้ออกแบบมาเพื่อรองรับการคำนวณจำนวนมากและงานที่ต้องใช้ข้อมูลจำนวนมาก แต่จะบรรลุความเข้ากันได้กับแอปพลิเคชันการประมวลผลและข้อมูลจำนวนมากเหล่านี้ได้อย่างไร ที่นี่เราจำเป็นต้องแนะนำตัวประมวลผลร่วม Ethereum chain เองทำหน้าที่เป็น CPU และตัวประมวลผลร่วมนั้นคล้ายกับ GPU แอปพลิเคชันต้องการใช้ข้อมูลหรือการคำนวณอย่างยืดหยุ่น ทรัพยากรสามารถใช้ตัวประมวลผลร่วมได้ ด้วยการสำรวจเทคโนโลยี ZK เพื่อให้แน่ใจว่าโปรเซสเซอร์ร่วมทำการคำนวณและใช้ข้อมูลนอกเครือข่ายโดยไม่น่าเชื่อถือ เป็นเรื่องปกติที่โปรเซสเซอร์ร่วมส่วนใหญ่จะได้รับการพัฒนาโดยมี ZK เป็นเลเยอร์พื้นฐาน

สำหรับ ZK Coporcessor ขอบเขตการใช้งานนั้นกว้างมากจนสามารถครอบคลุมสถานการณ์การใช้งานแอปพลิเคชัน dapp จริง ๆ ได้ เช่น เครือข่ายสังคม เกม การสร้างบล็อค Defi ระบบควบคุมความเสี่ยงตามข้อมูลออนไลน์ Oracle การจัดเก็บข้อมูล การฝึกอบรมภาษาโมเดลขนาดใหญ่ การอนุมาน ฯลฯ ตามทฤษฎี สิ่งใดก็ตามที่แอปพลิเคชัน Web2 สามารถทำได้นั้นสามารถทำได้ด้วยตัวประมวลผลร่วม ZK และ Ethereum จะทำหน้าที่เป็นเลเยอร์การชำระเงินขั้นสุดท้ายเพื่อปกป้องความปลอดภัยของแอปพลิเคชัน

ในโลกแบบดั้งเดิม ไม่มีคำจำกัดความที่ชัดเจนของตัวประมวลผลร่วม ตราบใดที่ชิปที่แยกจากกันสามารถใช้เป็นตัวเสริมเพื่อช่วยในการทำงานให้เสร็จสิ้นได้ ชิปนั้นเรียกว่าตัวประมวลผลร่วม คำจำกัดความทางอุตสาหกรรมในปัจจุบันของโปรเซสเซอร์ร่วม ZK นั้นไม่เหมือนกันทุกประการ ZK-Query, ZK-Oracle, ZKM ฯลฯ ล้วนเป็นโปรเซสเซอร์ร่วมที่สามารถช่วยในการสืบค้นข้อมูลที่สมบูรณ์บนห่วงโซ่ ข้อมูลที่เชื่อถือได้นอกห่วงโซ่ และ ผลการคำนวณนอกห่วงโซ่ เมื่อพิจารณาจากคำจำกัดความนี้ จริงๆ แล้วเลเยอร์ 2 ถือเป็นโปรเซสเซอร์ร่วมของ Ethereum นอกจากนี้ เราจะเปรียบเทียบความเหมือนและความแตกต่างระหว่างเลเยอร์ 2 และโปรเซสเซอร์ร่วม ZK ด้านล่าง

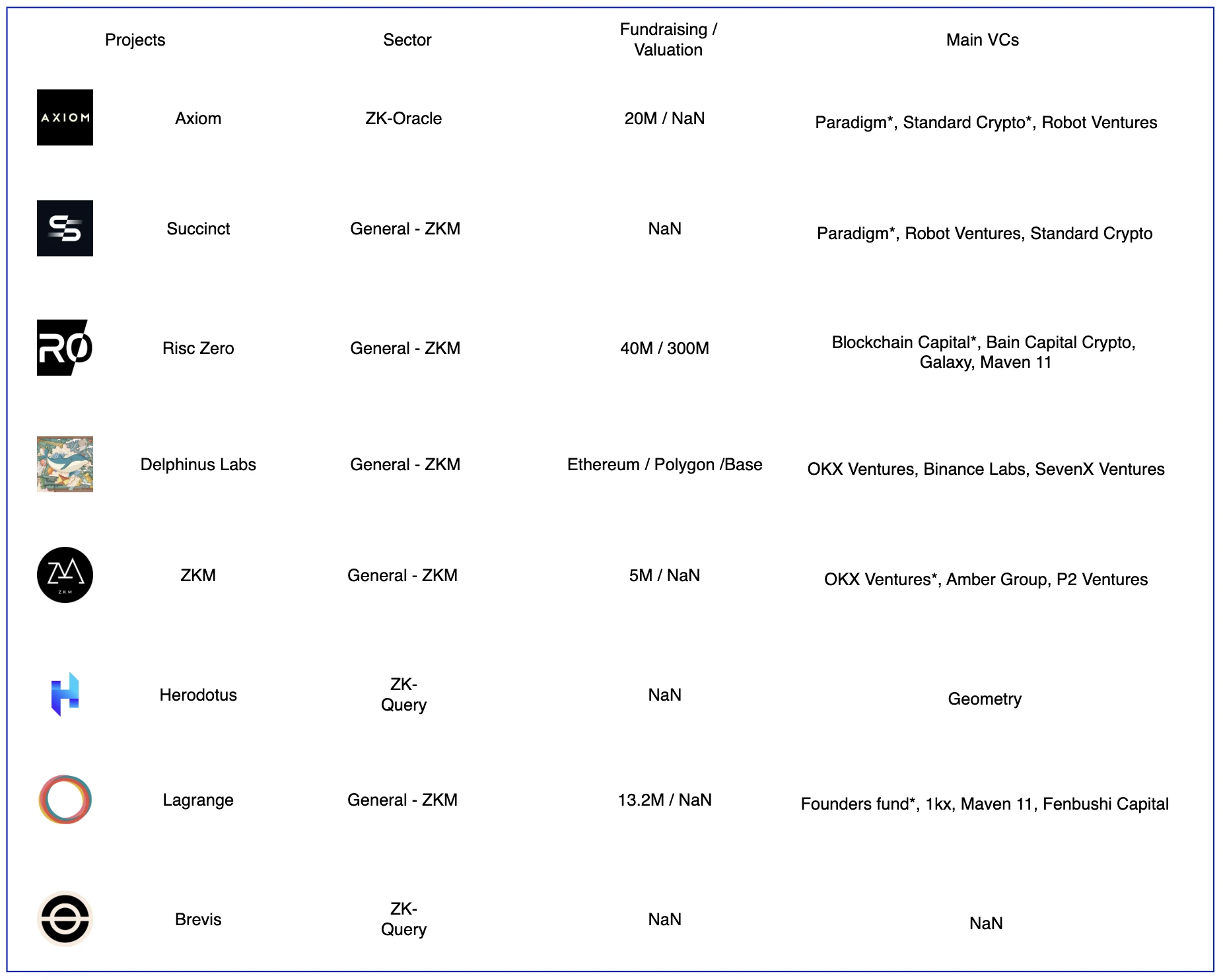

รายชื่อโปรเจ็กต์ตัวประมวลผลร่วม

โปรเจ็กต์บางส่วนของโปรเซสเซอร์ร่วม ZK ที่มา: Gate Ventures

ปัจจุบัน การประมวลผลร่วมที่ค่อนข้างเป็นที่รู้จักในอุตสาหกรรมแบ่งออกเป็นสามส่วนหลัก ได้แก่ การทำดัชนีข้อมูลแบบออนไลน์ oracles และ ZKML โปรเจ็กต์ที่รวมอยู่ในทั้งสามสถานการณ์คือ General-ZKM และเครื่องเสมือนที่ทำงานอยู่ off-chain มีความแตกต่าง ตัวอย่างเช่น Delphinus มุ่งเน้นไปที่ zkWASM ในขณะที่ Risc Zero มุ่งเน้นไปที่สถาปัตยกรรม Risc-V

สถาปัตยกรรมเทคโนโลยีโปรเซสเซอร์ร่วม

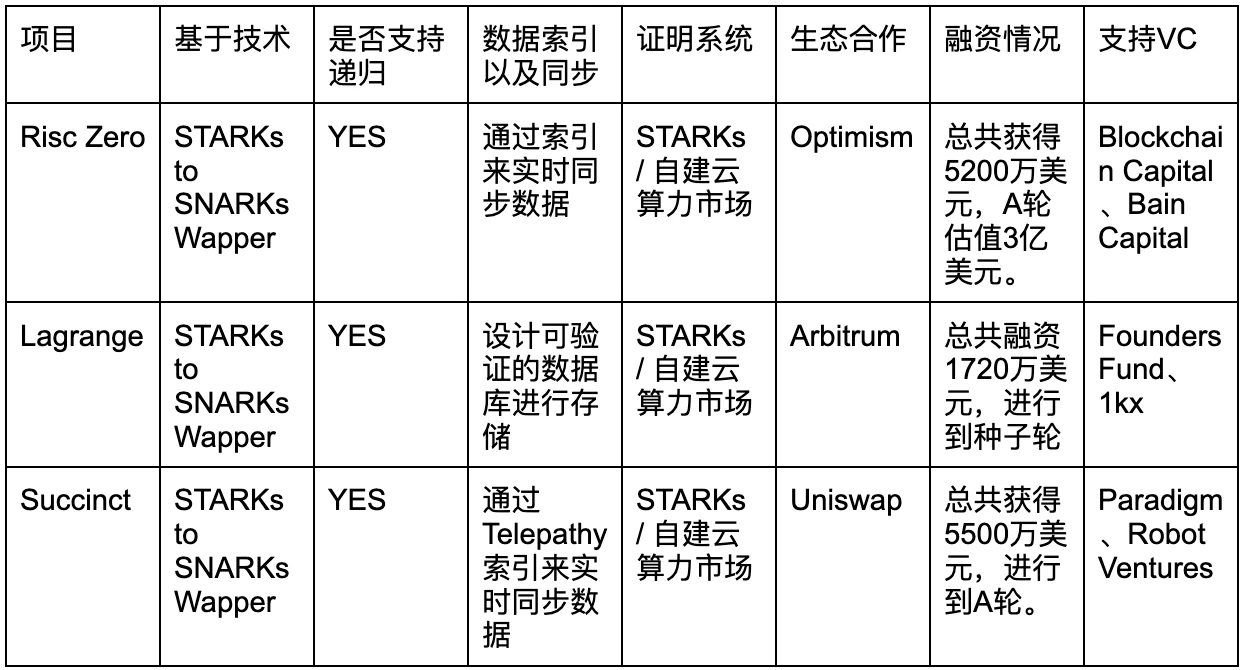

เราใช้ตัวประมวลผลร่วม General ZK เป็นตัวอย่างในการวิเคราะห์สถาปัตยกรรมเพื่อให้ผู้อ่านเข้าใจความเหมือนและความแตกต่างในการออกแบบเทคโนโลยีและกลไกของเครื่องเสมือนสำหรับใช้งานทั่วไปนี้ และเพื่อตัดสินแนวโน้มการพัฒนาในอนาคตของตัวประมวลผลร่วม ซึ่งส่วนใหญ่เกี่ยวข้องกับ Risc Three วิเคราะห์โครงการต่างๆ รวมถึง Zero, Lagrange และ Succinct

ริสซีซีโร่

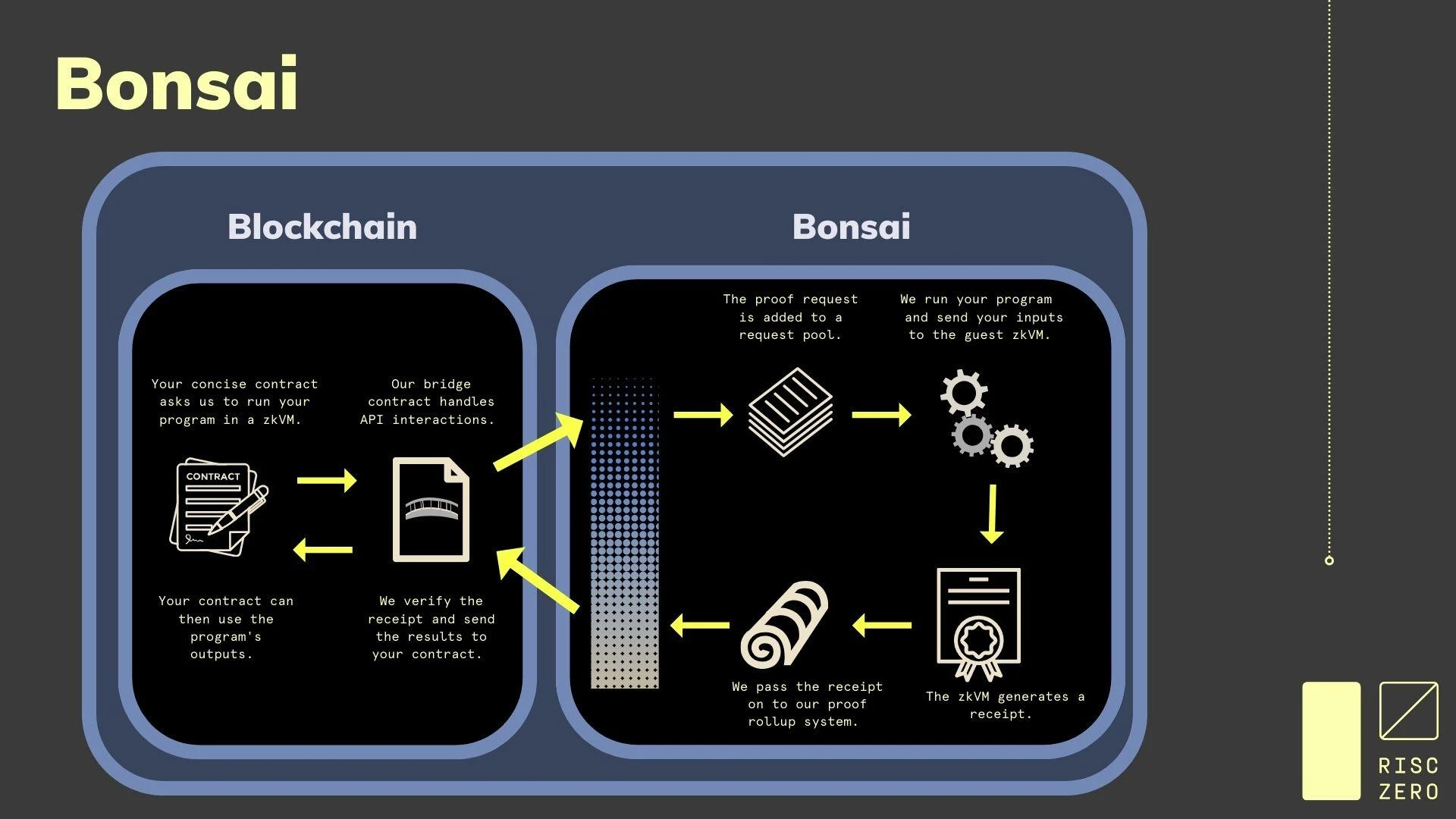

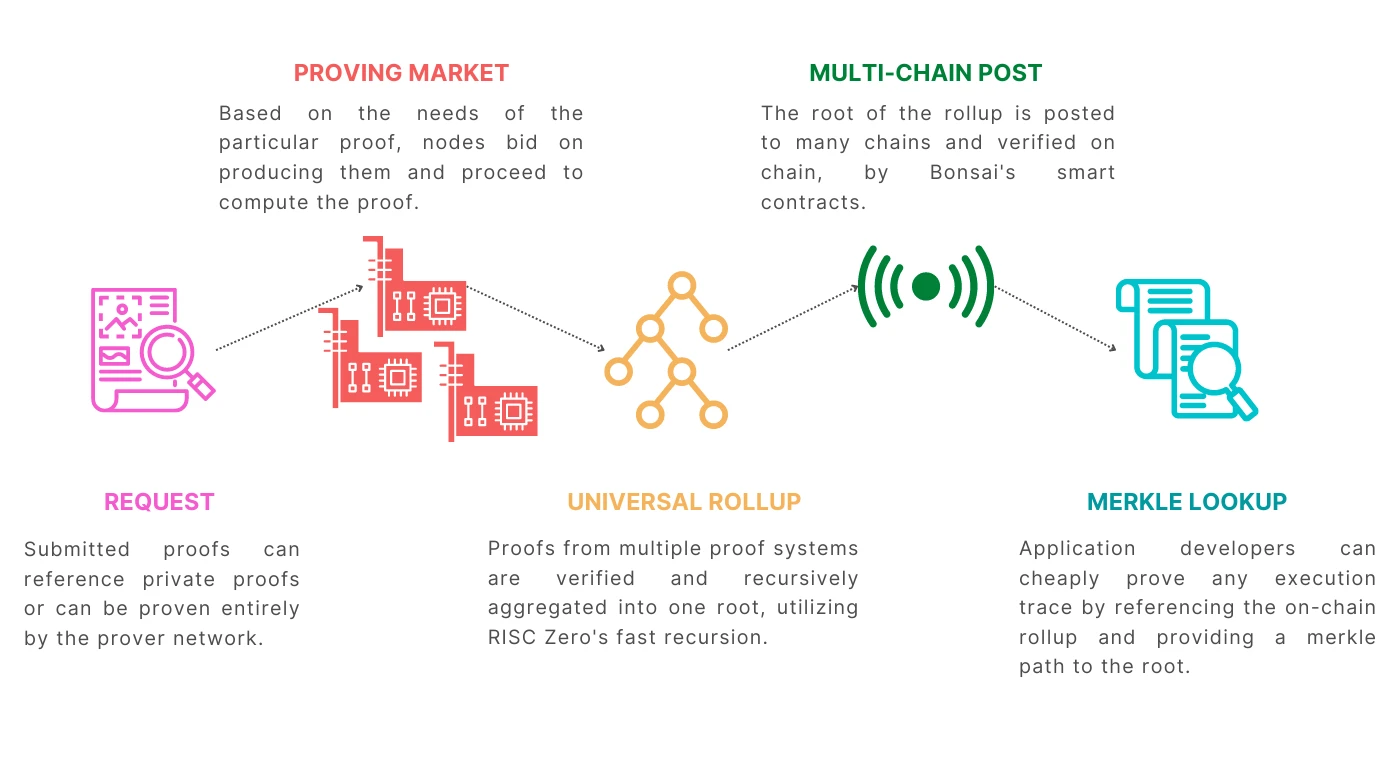

ใน Risc Zero ตัวประมวลผลร่วม ZK เรียกว่าบอนไซ

สถาปัตยกรรมบอนไซ ที่มา: Risc Zero

ส่วนประกอบบอนไซ ที่มา: Risc Zero

ในบอนไซ ชุดของส่วนประกอบพิสูจน์ความรู้แบบโซ่อิสระได้ถูกสร้างขึ้น เป้าหมายคือการกลายเป็นตัวประมวลผลร่วมที่ไม่ขึ้นกับโซ่ มันขึ้นอยู่กับสถาปัตยกรรมชุดคำสั่ง Risc-V และมีความคล่องตัวที่ยอดเยี่ยมและภาษาที่รองรับ . รวมถึง Rust, C++, Solidity, Go ฯลฯ หน้าที่หลักประกอบด้วย:

Universal zkVM สามารถรันเครื่องเสมือนใดๆ ในสภาพแวดล้อมที่ไม่มีความรู้/ตรวจสอบได้

ระบบสร้างหลักฐาน ZK ที่สามารถรวมเข้ากับสัญญาหรือห่วงโซ่อัจฉริยะใดๆ ได้โดยตรง

ภาพรวมทั่วไปที่กระจายการคำนวณการพิสูจน์บนบอนไซไปยังเชน ช่วยให้ผู้ขุดเครือข่ายสามารถสร้างการพิสูจน์ได้

ส่วนประกอบประกอบด้วย:

เครือข่าย Prover: ผู้พิสูจน์จะได้รับรหัส ZK ที่จำเป็นต้องได้รับการตรวจสอบในเครือข่ายผ่าน Bonsai API จากนั้นจึงเรียกใช้อัลกอริธึมการพิสูจน์เพื่อสร้างหลักฐาน ZK ในอนาคต

กลุ่มคำขอ: กลุ่มนี้จัดเก็บคำขอการรับรองที่เริ่มต้นโดยผู้ใช้ (คล้ายกับ mempool ของ Ethereum ที่ใช้ในการจัดเก็บธุรกรรมชั่วคราว) จากนั้นกลุ่มคำขอนี้จะถูกจัดเรียงตาม Sequencer เพื่อสร้างบล็อก และคำขอการรับรองจำนวนมากจะถูกแบ่งชี้ไปที่ ปรับปรุงประสิทธิภาพการพิสูจน์

กลไกสะสม: กลไกนี้จะรวบรวมผลลัพธ์การพิสูจน์ที่รวบรวมในเครือข่ายผู้พิสูจน์ จากนั้นรวมไว้ใน Root Proof และอัปโหลดไปยังเครือข่ายหลักของ Ethereum เพื่อให้ผู้ตรวจสอบความถูกต้องในเครือข่ายสามารถตรวจสอบได้ตลอดเวลา

Image Hub: นี่คือแพลตฟอร์มสำหรับนักพัฒนาภาพที่สามารถจัดเก็บฟังก์ชันและแอปพลิเคชันที่สมบูรณ์ได้ ดังนั้น นักพัฒนาจึงสามารถเรียก API ที่เกี่ยวข้องผ่านสัญญาอัจฉริยะได้

ร้านค้าของรัฐ: บอนไซยังได้แนะนำพื้นที่จัดเก็บข้อมูลแบบออฟไลน์ ซึ่งจัดเก็บในรูปแบบของคู่คีย์-ค่าในฐานข้อมูล ซึ่งสามารถลดต้นทุนการจัดเก็บข้อมูลบนเครือข่าย และร่วมมือกับแพลตฟอร์ม ImageHub เพื่อลดความซับซ้อนของสัญญาอัจฉริยะ

ตลาดที่พิสูจน์แล้ว: ZK พิสูจน์ให้เห็นถึงระดับกลางและระดับบนของห่วงโซ่อุตสาหกรรม และตลาดพลังงานการประมวลผลถูกนำมาใช้เพื่อให้ตรงกับด้านอุปสงค์และอุปทานของพลังการประมวลผล

ลากรองจ์

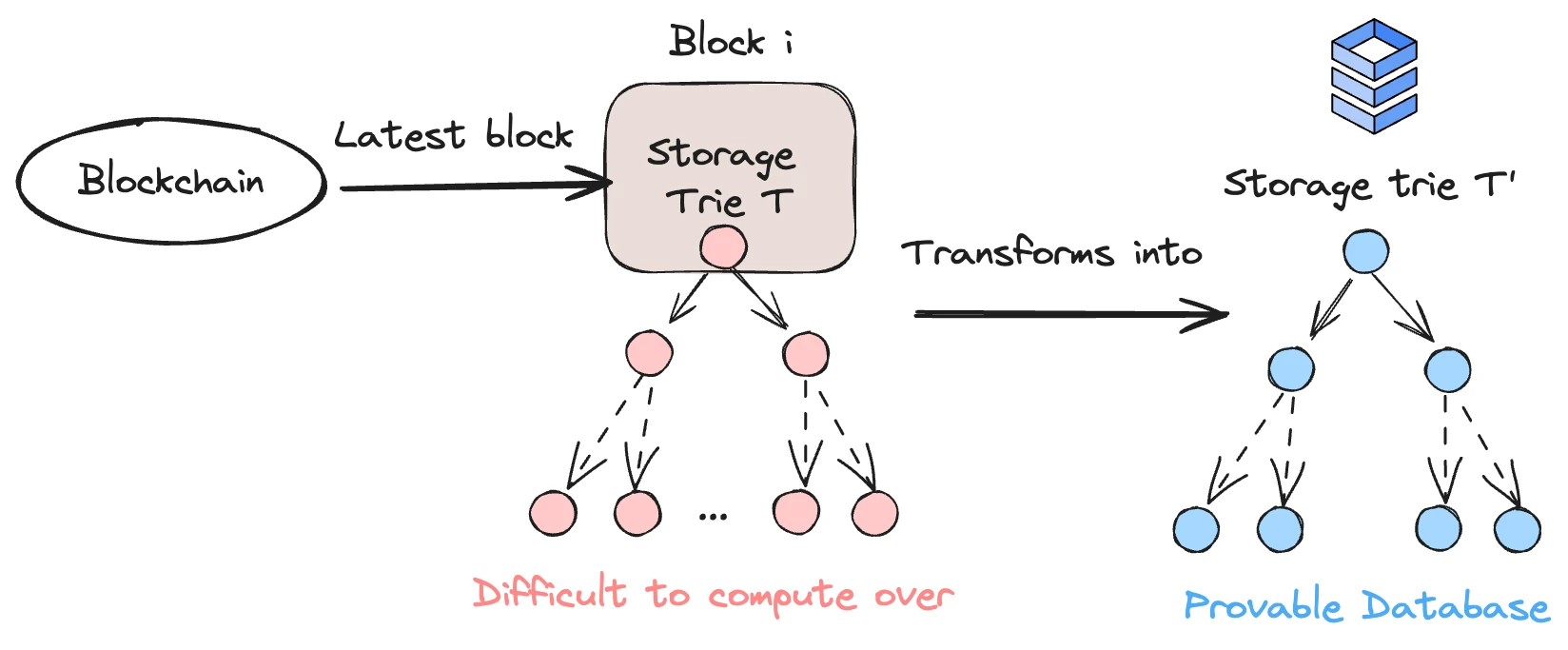

เป้าหมายของ Lagrange คือการสร้างตัวประมวลผลร่วมและฐานข้อมูลที่ตรวจสอบได้ซึ่งรวมถึงข้อมูลประวัติบนบล็อกเชน และสามารถใช้ข้อมูลนี้เพื่อสร้างแอปพลิเคชันที่ไม่น่าเชื่อถือได้อย่างราบรื่น ซึ่งช่วยให้สามารถพัฒนาแอปพลิเคชันด้านการประมวลผลและข้อมูลจำนวนมากได้

สิ่งนี้เกี่ยวข้องกับสองฟังก์ชัน:

ฐานข้อมูลที่ตรวจสอบได้: ด้วยการจัดทำดัชนีการจัดเก็บของสัญญาอัจฉริยะบนลูกโซ่ สถานะออนไลน์ที่สร้างโดยสัญญาอัจฉริยะจะถูกใส่เข้าไปในฐานข้อมูล โดยพื้นฐานแล้ว พื้นที่เก็บข้อมูล สถานะ และบล็อกของบล็อกเชนจะถูกสร้างขึ้นใหม่ จากนั้นจัดเก็บในลักษณะที่อัปเดตในฐานข้อมูลนอกเครือข่ายที่สามารถเรียกค้นได้อย่างง่ายดาย

การคำนวณตามหลักการ MapReduce: หลักการ MapReduce คือการใช้การแยกข้อมูลและการประมวลผลแบบขนานหลายอินสแตนซ์บนฐานข้อมูลขนาดใหญ่ และสุดท้ายก็รวมผลลัพธ์เข้าด้วยกัน สถาปัตยกรรมที่รองรับการดำเนินการแบบขนานนี้เรียกว่า zkMR โดย Lagrange

ในการออกแบบฐานข้อมูลนั้นเกี่ยวข้องกับข้อมูลออนไลน์ทั้งหมดสามส่วน ได้แก่ ข้อมูลการจัดเก็บสัญญา ข้อมูลสถานะ EOA และข้อมูลบล็อก

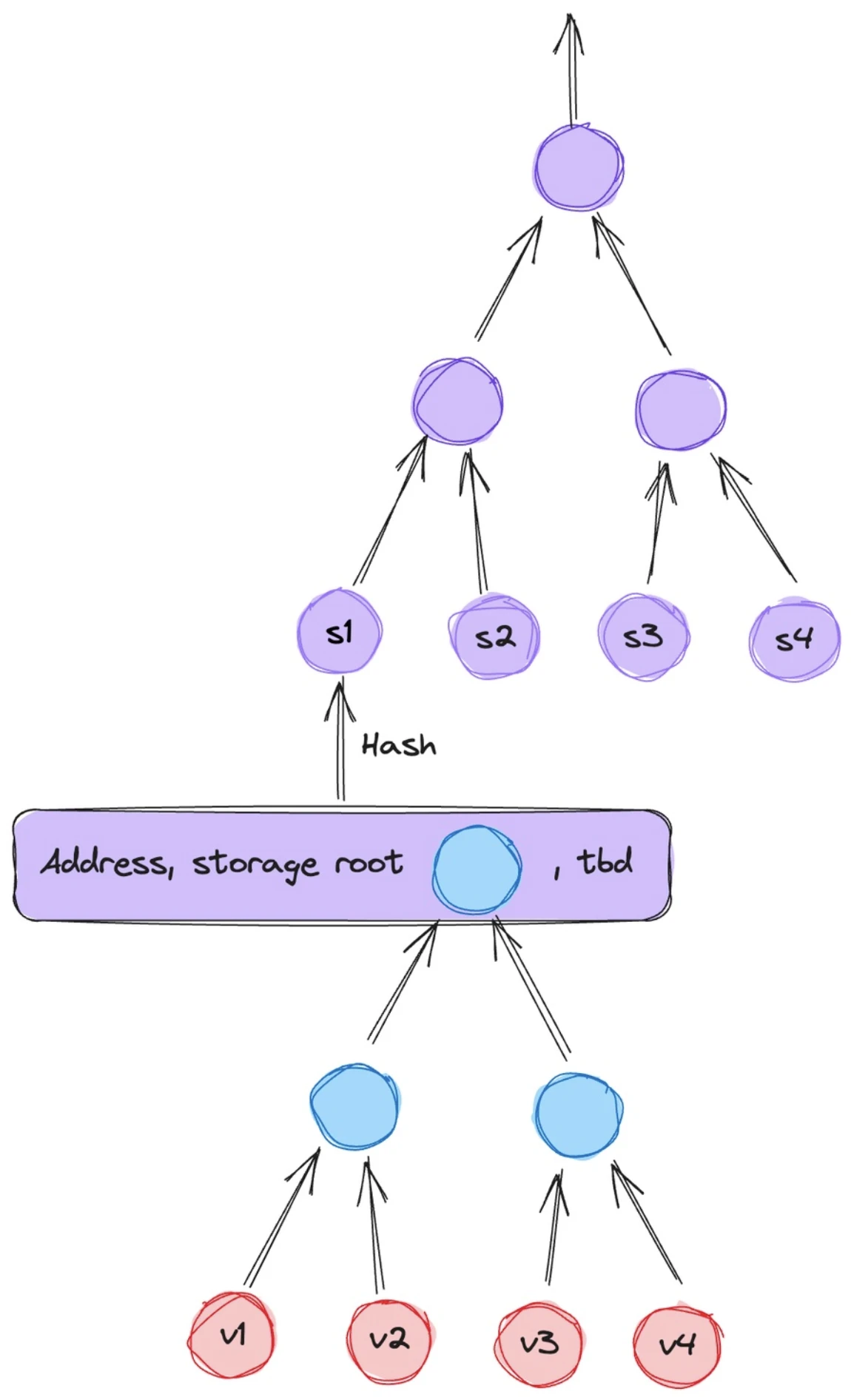

โครงสร้างฐานข้อมูลลากรองจ์ ที่มา: ลากรองจ์

ด้านบนนี้เป็นโครงสร้างการแมปของข้อมูลที่จัดเก็บไว้ในสัญญา ตัวแปรสถานะของสัญญาจะถูกจัดเก็บไว้ที่นี่ และแต่ละสัญญาจะมี Storage Trie ที่เป็นอิสระ แม้ว่าแผนผัง MPT จะเรียบง่าย แต่ประสิทธิภาพก็ต่ำมาก ซึ่งเป็นเหตุผลว่าทำไมนักพัฒนาหลักของ Ethereum จึงส่งเสริมการพัฒนาแผนผัง Verkel ในลากรองจ์ แต่ละโหนดสามารถ พิสูจน์ ได้โดยใช้ SNARK/STARK และโหนดหลักมีการพิสูจน์ของโหนดลูก ซึ่งต้องใช้เทคโนโลยีการพิสูจน์แบบเรียกซ้ำ

สถานะบัญชี ที่มา: Lagrange

บัญชีเป็น EOA และบัญชีสัญญาซึ่งสามารถจัดเก็บได้ในรูปแบบ Account/Storage Root (พื้นที่เก็บข้อมูลของตัวแปรสัญญา) เพื่อแสดงสถานะบัญชี แต่ดูเหมือนว่า Lagrange ยังออกแบบส่วนนี้ไม่เต็มที่และจำเป็นต้องเพิ่มจริง ๆ State Trie (รูทของพื้นที่เก็บข้อมูลสถานะของบัญชีภายนอก)

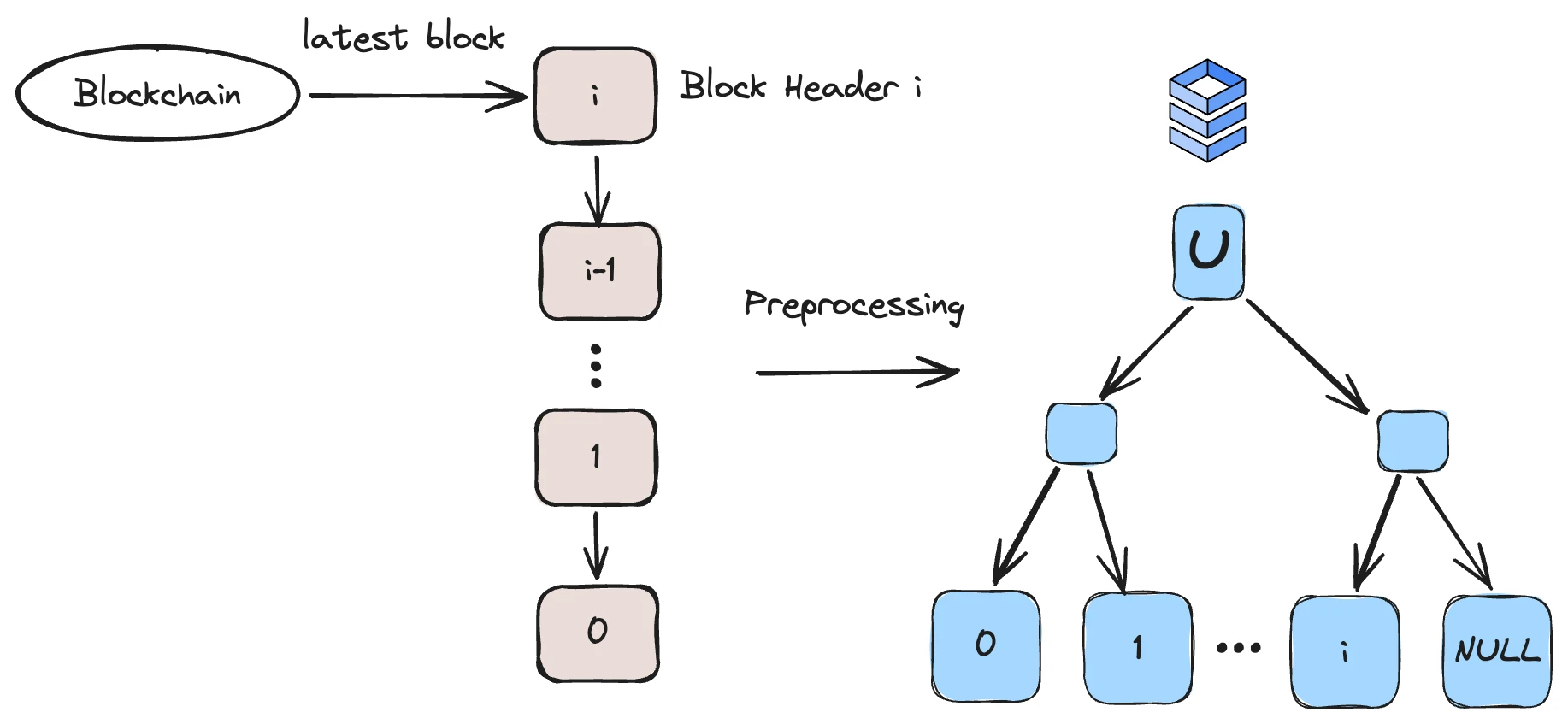

โครงสร้างข้อมูลบล็อก ที่มา: ลากรองจ์

ในโครงสร้างข้อมูลใหม่ Lagrange ได้สร้างโครงสร้างข้อมูลบล็อกที่เป็นมิตรกับ SNARKs proofs แต่ละ leaf ของ tree จะเป็นส่วนหัวของบล็อก ขนาดของตัวเลขนี้จะได้รับการแก้ไข หาก Ethereum สร้างบล็อกทุกๆ 12 วินาที ดังนั้นฐานข้อมูล จะมีอายุประมาณ 25 ปี

ในเครื่องเสมือน ZKMR ของ Lagrange การคำนวณมีสองขั้นตอน:

แผนที่: เครื่องแบบกระจายจะจับคู่ข้อมูลทั้งหมดและสร้างคู่คีย์-ค่า

ลด: คอมพิวเตอร์แบบกระจายจะคำนวณการพิสูจน์แยกกัน จากนั้นจึงรวมการพิสูจน์ทั้งหมด

กล่าวโดยย่อ ZKMR สามารถรวมการพิสูจน์การคำนวณที่มีขนาดเล็กลงเพื่อสร้างการพิสูจน์การคำนวณทั้งหมดได้ ซึ่งช่วยให้ ZKMR สามารถปรับขนาดได้อย่างมีประสิทธิภาพเพื่อพิสูจน์การคำนวณที่ซับซ้อนกับชุดข้อมูลขนาดใหญ่ที่ต้องใช้การคำนวณหลายขั้นตอนหรือหลายชั้น ตัวอย่างเช่น หากใช้งาน Uniswap บน 100 chains หากคุณต้องการคำนวณราคา TWAP ของโทเค็นบางตัวบน 100 chain จะต้องคำนวณและบูรณาการจำนวนมาก ในเวลานี้ ZKMR สามารถคำนวณแต่ละ chain แยกกันได้ นำมารวมกันเป็นหลักฐานการคำนวณที่สมบูรณ์

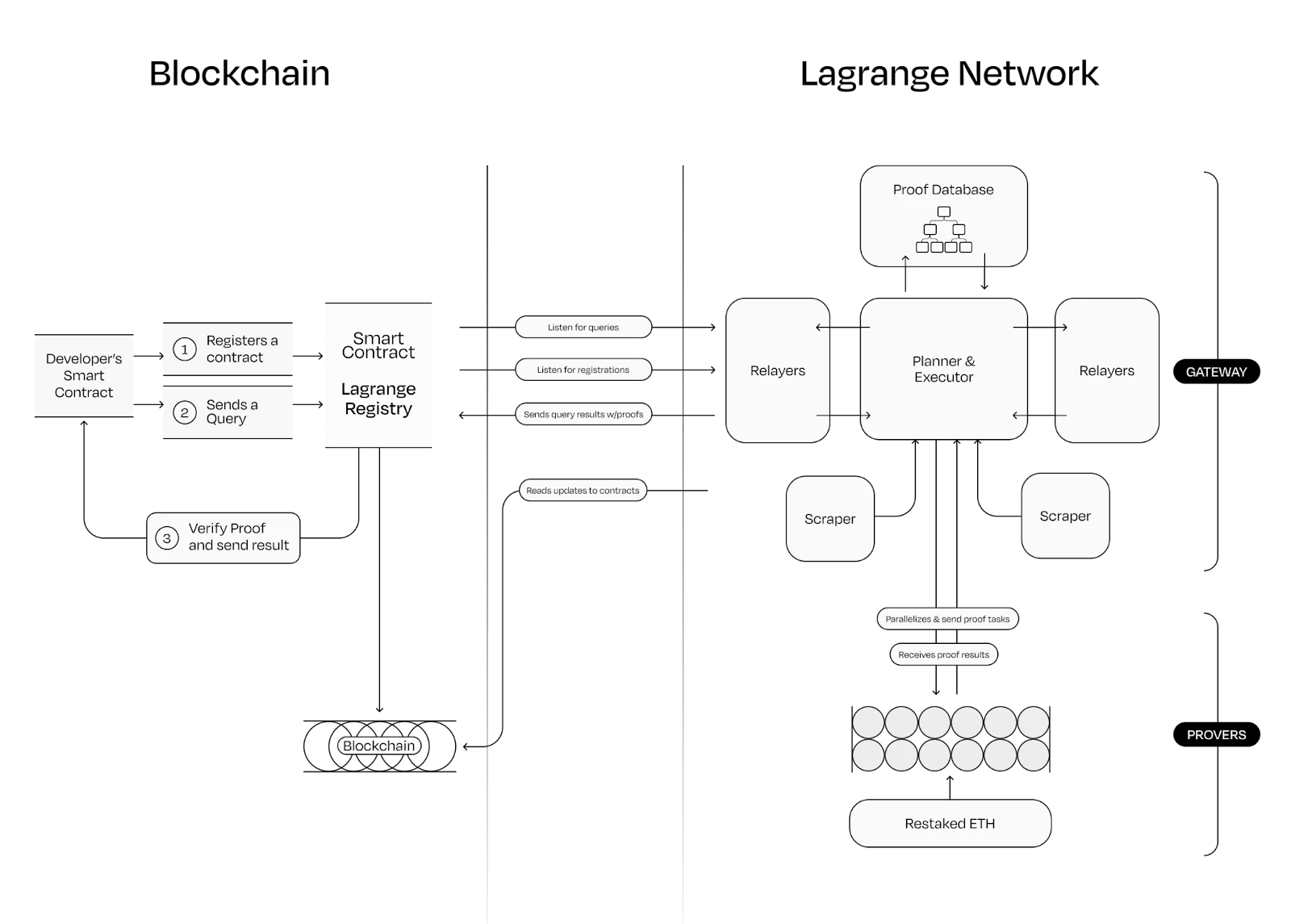

กระบวนการดำเนินการตัวประมวลผลร่วมลากรองจ์ แหล่งที่มา: ลากรองจ์

ข้างต้นคือกระบวนการดำเนินการ:

สัญญาอัจฉริยะของนักพัฒนาจะลงทะเบียนบน Lagrange ก่อน จากนั้นจึงส่งคำขอพิสูจน์ไปยังสัญญาอัจฉริยะแบบออนไลน์ของ Lagrange ในเวลานี้ สัญญาพร็อกซีมีหน้าที่รับผิดชอบในการโต้ตอบกับสัญญาของนักพัฒนา

Lagrange แบบออฟไลน์ร่วมตรวจสอบโดยแยกคำขอออกเป็นงานเล็กๆ ที่สามารถขนานกันได้ และแจกจ่ายให้กับผู้พิสูจน์ต่างๆ

จริงๆ แล้วเครื่องพิสูจน์ก็คือเครือข่าย และความปลอดภัยของเครือข่ายนั้นรับประกันโดยเทคโนโลยี Reslogging ของ EigenLayer

รวบรัด

เป้าหมายของ Succinct Network คือการผสานรวมข้อเท็จจริงที่ตั้งโปรแกรมได้เข้ากับทุกส่วนของสแต็กการพัฒนาบล็อกเชน (รวมถึง L2, โปรเซสเซอร์ร่วม, สะพานข้ามสายโซ่ ฯลฯ)

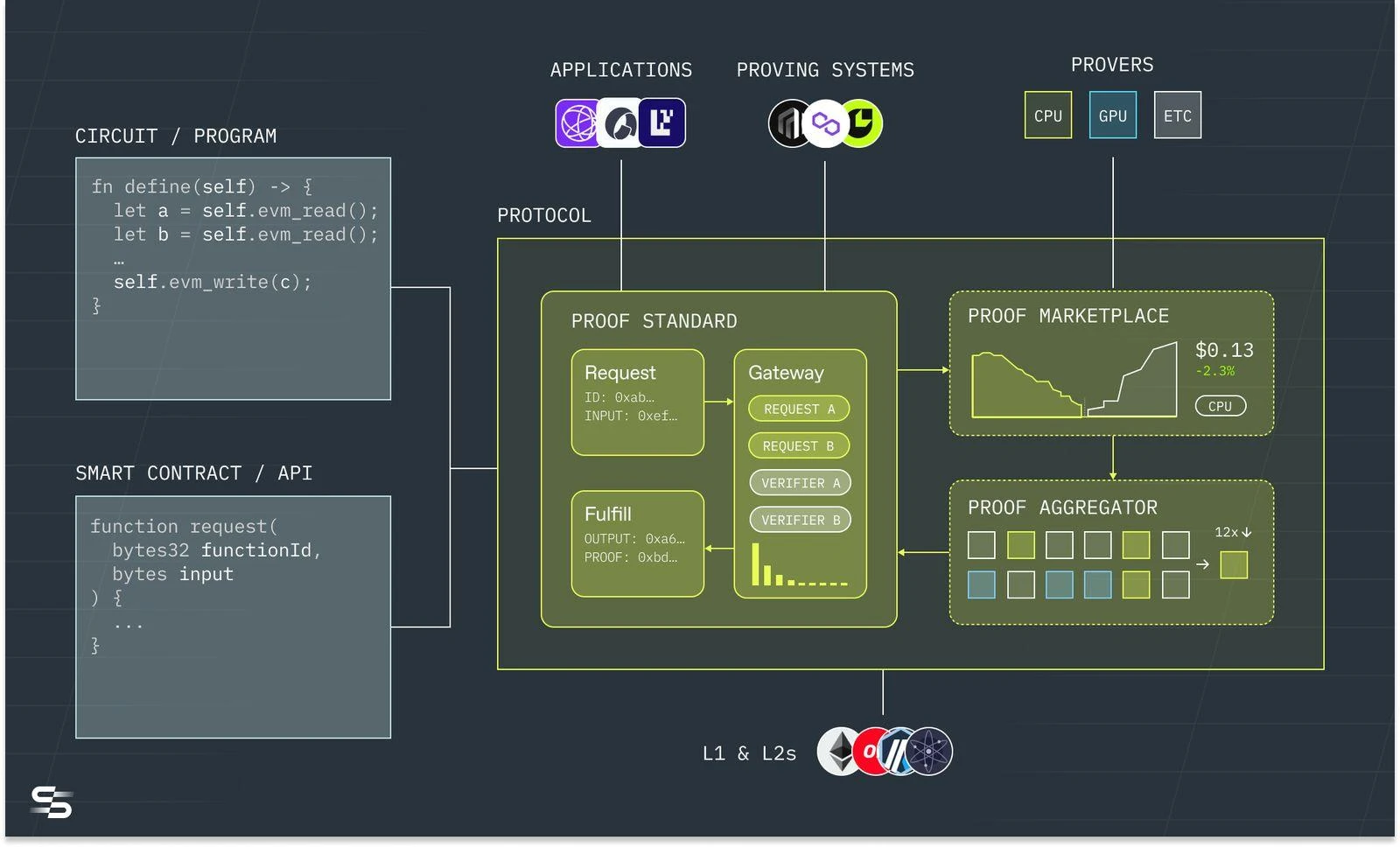

กระบวนการดำเนินงานโดยย่อ แหล่งที่มาของภาพ: รวบรัด

Succinct สามารถรับรหัสรวมถึง Solidity และภาษาเฉพาะทาง (DSL) ในช่องที่ไม่มีความรู้ และส่งต่อไปยังตัวประมวลผลร่วม Succinct แบบออฟไลน์ ตลาดซึ่งสามารถรองรับ CPU, Miners ของ GPU และชิป ETC ส่งหลักฐานในเครือข่ายพิสูจน์ คุณลักษณะของมันคือตลาดการพิสูจน์สามารถเข้ากันได้กับระบบการพิสูจน์ต่างๆ เนื่องจากจะต้องมีระยะเวลานานที่ระบบการพิสูจน์ต่างๆ จะอยู่ร่วมกันในอนาคต

ZKVM นอกเครือข่ายของ Succinct เรียกว่า SP (Succinct Processor) ซึ่งสามารถรองรับภาษา Rust และภาษา LLVM อื่นๆ ได้

การเรียกซ้ำ + การตรวจสอบ: เทคโนโลยีการตรวจสอบแบบเรียกซ้ำที่ใช้เทคโนโลยี STARKs สามารถเพิ่มประสิทธิภาพการบีบอัด ZK ได้อย่างทวีคูณ

รองรับการห่อ SNARK ถึง STARK: สามารถใช้ประโยชน์จากทั้ง SNARK และ STARK และแก้ปัญหาการแลกเปลี่ยนระหว่างขนาดการพิสูจน์และเวลาในการตรวจสอบ

สถาปัตยกรรม zkVM ที่เน้นการคอมไพล์ล่วงหน้า: สำหรับอัลกอริธึมทั่วไปบางอย่าง เช่น SHA 256, Keccak, ECDSA ฯลฯ สามารถคอมไพล์ล่วงหน้าได้เพื่อลดเวลาการสร้างการพิสูจน์รันไทม์และเวลาการตรวจสอบ

เปรียบเทียบ

เมื่อเปรียบเทียบโปรเซสเซอร์ร่วม ZK สำหรับงานทั่วไป เราจะทำการเปรียบเทียบที่เป็นไปตามหลักการข้อแรกของ Mass Adoption เป็นหลัก นอกจากนี้ เราจะอธิบายด้วยว่าเหตุใดจึงมีความสำคัญ:

ปัญหาการจัดทำดัชนี/การซิงโครไนซ์ข้อมูล: เฉพาะข้อมูลออนไลน์ที่สมบูรณ์และฟังก์ชันการจัดทำดัชนีที่ซิงโครไนซ์เท่านั้นที่สามารถตอบสนองความต้องการของแอปพลิเคชันที่ใช้ข้อมูลขนาดใหญ่ มิฉะนั้นขอบเขตแอปพลิเคชันจะค่อนข้างเดียว

ขึ้นอยู่กับเทคโนโลยี: เทคโนโลยี SNARK และ STARK มีจุดตัดสินใจที่แตกต่างกัน ในระยะกลาง เทคโนโลยี SNARK จะเป็นเทคโนโลยีหลัก และในระยะยาว เทคโนโลยี STARK จะเป็นเทคโนโลยีหลัก

ไม่ว่าจะสนับสนุนการเรียกซ้ำหรือไม่: มีเพียงการสนับสนุนการเรียกซ้ำเท่านั้นที่เราสามารถบีบอัดข้อมูลในระดับที่มากขึ้นและบรรลุผลการคำนวณแบบขนาน ดังนั้นการบรรลุการเรียกซ้ำที่สมบูรณ์จึงเป็นจุดเด่นทางเทคนิคของโครงการ

ระบบพิสูจน์อักษร: ระบบพิสูจน์อักษรส่งผลโดยตรงต่อขนาดและเวลาของการสร้างหลักฐาน นี่เป็นส่วนที่แพงที่สุดของเทคโนโลยี ZK ในปัจจุบัน ตลาดพลังการประมวลผลบนคลาวด์ ZK ที่สร้างขึ้นเองและเครือข่ายพิสูจน์อักษรเป็นตลาดหลัก

ความร่วมมือเชิงนิเวศ: สามารถตัดสินได้ว่าผู้ใช้ B-end ยอมรับทิศทางทางเทคนิคผ่านด้านอุปสงค์ที่แท้จริงที่สามหรือไม่

การสนับสนุน VC และสถานะทางการเงิน: อาจสามารถระบุการสนับสนุนทรัพยากรในภายหลังได้

ในความเป็นจริง เส้นทางทางเทคนิคโดยรวมมีความชัดเจนมาก ดังนั้นเทคโนโลยีส่วนใหญ่จึงมาบรรจบกัน ตัวอย่างเช่น เทคโนโลยีทั้งหมดใช้ wrappers จาก STARK ไปจนถึง SNARK ซึ่งสามารถใช้ประโยชน์จาก STARK และ SNARK ได้ในเวลาเดียวกัน ช่วยลดเวลาในการสร้างหลักฐานและเวลาในการตรวจสอบ และต้านทานการโจมตีควอนตัม เนื่องจากการเรียกซ้ำของอัลกอริธึม ZK อาจส่งผลกระทบอย่างมากต่อประสิทธิภาพของ ZK ในปัจจุบันทั้งสามโปรเจ็กต์จึงมีฟังก์ชันแบบเรียกซ้ำ การสร้างอัลกอริธึม ZK พิสูจน์ได้คือจุดที่ต้นทุนและเวลาถูกใช้ไปมากที่สุด ดังนั้น ทั้งสามโครงการจึงอาศัยความต้องการพลังการประมวลผล ZK ที่แข็งแกร่งเพื่อสร้างเครือข่ายพิสูจน์และตลาดพลังการประมวลผลบนคลาวด์ ด้วยเหตุนี้ เมื่อเส้นทางทางเทคนิคในปัจจุบันคล้ายกันมาก อาจจำเป็นมากขึ้นที่จะต้องเจาะทะลุทีมและ VC ที่อยู่เบื้องหลังพวกเขา เพื่อช่วยเหลือในทรัพยากรความร่วมมือทางนิเวศวิทยาเพื่อครอบครองส่วนแบ่งการตลาด

ความเหมือนและความแตกต่างระหว่างโปรเซสเซอร์ร่วมและเลเยอร์ 2

ต่างจากเลเยอร์ 2 ตรงที่ตัวประมวลผลร่วมนั้นเน้นไปที่แอปพลิเคชัน ในขณะที่เลเยอร์ 2 ยังคงเป็นแบบเน้นผู้ใช้ ตัวประมวลผลร่วมสามารถใช้เป็นส่วนประกอบการเร่งความเร็วหรือส่วนประกอบแบบโมดูลาร์เพื่อสร้างสถานการณ์การใช้งานต่อไปนี้:

ในฐานะส่วนประกอบเครื่องเสมือนนอกเครือข่ายของ ZK Layer 2 เลเยอร์ 2 เหล่านี้สามารถแทนที่ VM ของตัวเองด้วยโปรเซสเซอร์ร่วม

เป็นโปรเซสเซอร์ร่วมสำหรับแอปพลิเคชันบนเครือข่ายสาธารณะเพื่อลดภาระการประมวลผลนอกเครือข่าย

เป็นออราเคิลสำหรับแอปพลิเคชันบนเชนสาธารณะเพื่อรับข้อมูลที่ตรวจสอบได้จากเชนอื่น

ทำหน้าที่เป็นสะพานข้ามสายโซ่ระหว่างสองสายโซ่เพื่อส่งข้อความ

สถานการณ์การใช้งานเหล่านี้เป็นเพียงรายการบางส่วน สำหรับโปรเซสเซอร์ร่วม เราต้องเข้าใจว่าสิ่งนี้นำศักยภาพของการซิงโครไนซ์ข้อมูลแบบเรียลไทม์และการประมวลผลที่เชื่อถือได้ประสิทธิภาพสูงและต้นทุนต่ำมาทั่วทั้งห่วงโซ่ และสามารถสร้างใหม่ได้อย่างปลอดภัย บล็อกเกือบทั้งหมดผ่านตัวประมวลผลร่วม รวมถึง Chainlink และ The Graph กำลังพัฒนา ZK oracles ของตัวเอง และ Cross-chain Bridge เช่น Wormhole, Layerzero ฯลฯ ก็กำลังพัฒนาเทคโนโลยี Cross-chain Bridge โดยใช้ ZK off-chain LLM (oracles ขนาดใหญ่) และการให้เหตุผลที่เชื่อถือได้ เป็นต้น

ปัญหาที่โปรเซสเซอร์ร่วมเผชิญ

มีการต่อต้านสำหรับนักพัฒนาที่จะเข้ามา เทคโนโลยี ZK นั้นเป็นไปได้ในทางทฤษฎี แต่ยังคงมีปัญหาทางเทคนิคมากมายและความเข้าใจภายนอกก็ไม่ชัดเจนเช่นกัน ดังนั้น เมื่อนักพัฒนารายใหม่เข้าสู่ระบบนิเวศ พวกเขาจำเป็นต้องเชี่ยวชาญภาษาเฉพาะและเครื่องมือสำหรับนักพัฒนา อาจมีความต้านทานมากขึ้น

การติดตามยังอยู่ในช่วงเริ่มต้น ประสิทธิภาพของ zkVM มีความซับซ้อนมากและเกี่ยวข้องกับหลายมิติ (รวมถึงฮาร์ดแวร์ ประสิทธิภาพโหนดเดียวและหลายโหนด การใช้หน่วยความจำ ต้นทุนการเรียกซ้ำ การเลือกฟังก์ชันแฮช และปัจจัยอื่น ๆ ) โครงการที่อยู่ระหว่างการก่อสร้างในมิติต่างๆ ยังอยู่ในช่วงเริ่มต้นและรูปแบบยังไม่ชัดเจน

ข้อกำหนดเบื้องต้น เช่น ฮาร์ดแวร์ ยังไม่ได้ถูกนำมาใช้ จากมุมมองของฮาร์ดแวร์ ฮาร์ดแวร์กระแสหลักในปัจจุบันถูกสร้างขึ้นโดยใช้ ASIC และ FPGA ผู้ผลิต ได้แก่ Ingonyama, Cysic ฯลฯ ซึ่งยังอยู่ในขั้นตอนห้องปฏิบัติการและยังไม่ได้ดำเนินการเชิงพาณิชย์ เราเชื่อว่าฮาร์ดแวร์คือเทคโนโลยี ZK

เส้นทางทางเทคนิคนั้นคล้ายคลึงกัน และเป็นเรื่องยากที่จะเป็นผู้นำทางเทคโนโลยีข้ามรุ่น ในปัจจุบัน การแข่งขันหลักคือทรัพยากร VC ที่อยู่เบื้องหลังและความสามารถของ BD ของทีม และไม่ว่าจะสามารถเอาชนะกลุ่มเฉพาะทางนิเวศวิทยาของแอปพลิเคชันกระแสหลักและเครือข่ายสาธารณะได้หรือไม่ .

สรุปและแนวโน้ม

เทคโนโลยี ZK มีความหลากหลายอย่างมาก และยังช่วยให้ระบบนิเวศ Ethereum ย้ายจากการวางแนวมูลค่าแบบกระจายอำนาจไปสู่การวางแนวมูลค่าที่ไม่น่าเชื่อถือ อย่าเชื่อถือ ตรวจสอบเลย ประโยคนี้เป็นแนวทางปฏิบัติที่ดีที่สุดของเทคโนโลยี ZK เทคโนโลยี ZK สามารถสร้างชุดสถานการณ์การใช้งานต่างๆ ขึ้นมาใหม่ได้ เช่น สะพานข้ามสายโซ่, ออราเคิล, การสืบค้นแบบออนไลน์, การคำนวณนอกสายโซ่, เครื่องเสมือน ฯลฯ และตัวประมวลผลร่วม ZK สำหรับวัตถุประสงค์ทั่วไปเป็นหนึ่งในเครื่องมือในการนำเทคโนโลยี ZK ไปใช้งาน . สำหรับ ZK Coporcessor ขอบเขตแอปพลิเคชันนั้นกว้างมากจนสามารถครอบคลุมสถานการณ์แอปพลิเคชัน dapp จริง ๆ ได้ ตามทฤษฎีแล้ว ทุกสิ่งที่แอปพลิเคชัน Web2 สามารถทำได้ด้วยตัวประมวลผลร่วม ZK

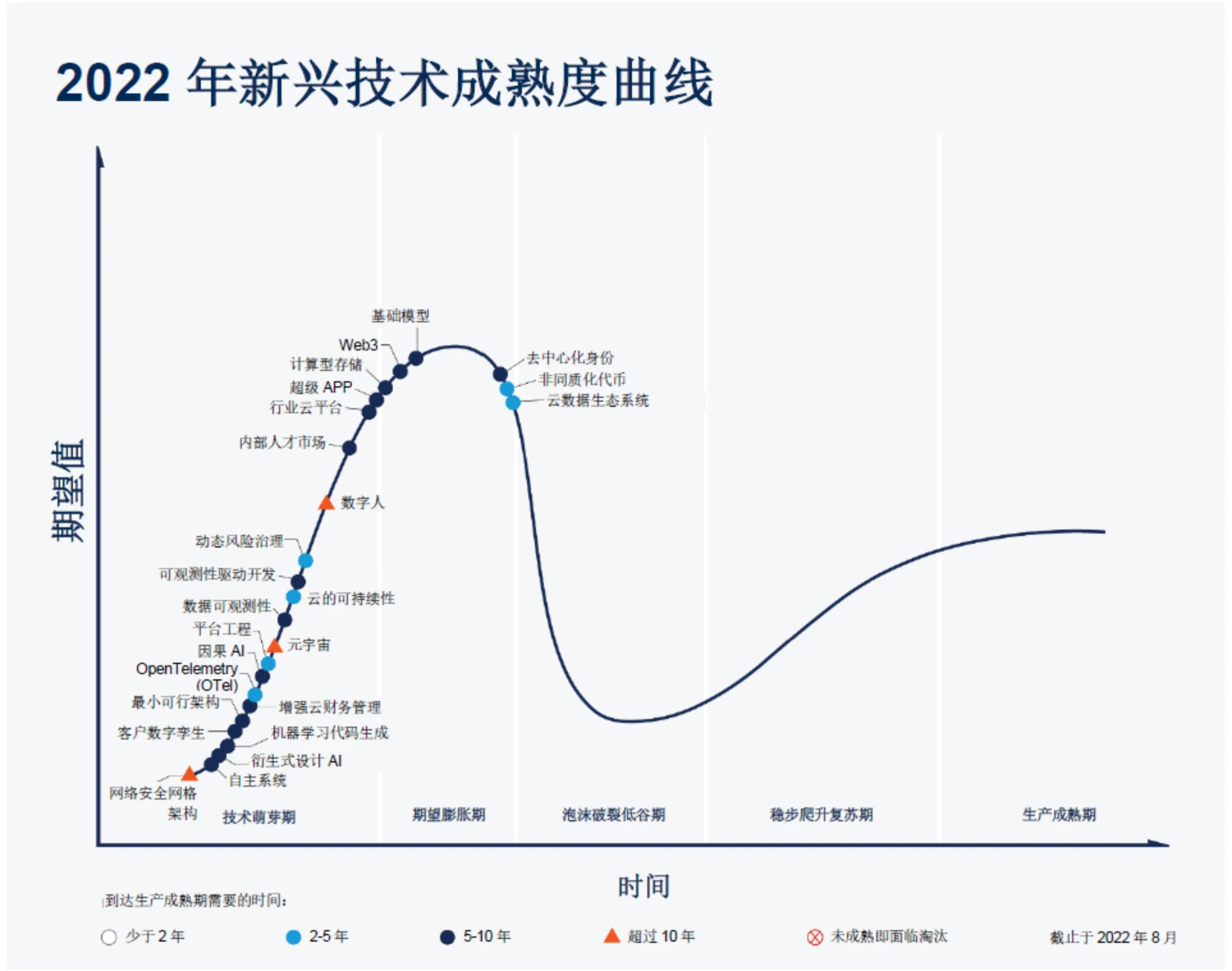

กราฟการเจาะลึกเทคโนโลยี ที่มา: Gartner

ตั้งแต่สมัยโบราณ การพัฒนาของเทคโนโลยีล้าหลังจินตนาการของมนุษย์ในเรื่องชีวิตที่ดีขึ้น (เช่น ฉางเอ๋อที่บินไปดวงจันทร์ถึงอพอลโลเหยียบบนดวงจันทร์) หากสิ่งใดสิ่งหนึ่งเป็นนวัตกรรมอย่างแท้จริง ซึ่งถูกโค่นล้มและจำเป็น เทคโนโลยีก็จะตามมาอย่างแน่นอน ตระหนักดีว่าต้องใช้เวลาตั้งคำถาม เราเชื่อว่าโปรเซสเซอร์ร่วม ZK สากลเป็นไปตามแนวโน้มการพัฒนานี้ เรามีตัวบ่งชี้สองตัวสำหรับโปรเซสเซอร์ร่วม ZK Mass Adoption: ฐานข้อมูลที่พิสูจน์ได้แบบเรียลไทม์ทั่วทั้งห่วงโซ่และการประมวลผลนอกห่วงโซ่ต้นทุนต่ำ หากปริมาณข้อมูลเพียงพอและการซิงโครไนซ์แบบเรียลไทม์ควบคู่ไปกับการคำนวณนอกระบบที่มีต้นทุนต่ำ กระบวนทัศน์การพัฒนาซอฟต์แวร์ก็สามารถเปลี่ยนแปลงได้อย่างสมบูรณ์ อย่างไรก็ตาม เป้าหมายนี้จะทำซ้ำอย่างช้าๆ ดังนั้นเราจึงมุ่งเน้นไปที่การค้นหาแนวโน้มหรือการวางแนวคุณค่า ที่สอดคล้องกับสองประเด็นนี้ และการนำชิปประมวลผล ZK มาใช้ถือเป็นข้อกำหนดเบื้องต้นสำหรับการประยุกต์ใช้โปรเซสเซอร์ร่วม ZK ในเชิงพาณิชย์ขนาดใหญ่ การขาดนวัตกรรมในวงจรนี้เป็นช่วงเวลาสำหรับการสร้างรุ่นต่อไปอย่างแท้จริง เทคโนโลยีและแอปพลิเคชัน Mass Adoption เราคาดว่าในรอบถัดไป ในระหว่างวงจรนี้ ห่วงโซ่อุตสาหกรรม ZK สามารถนำไปใช้ในเชิงพาณิชย์ได้ ดังนั้นตอนนี้ก็ถึงเวลาที่จะมุ่งเน้นไปที่เทคโนโลยีบางอย่างที่สามารถทำให้ Web3 สามารถโต้ตอบกับผู้คนได้ 1 พันล้านคนบน โซ่.

ข้อสงวนสิทธิ์:

เนื้อหาข้างต้นมีไว้เพื่อการอ้างอิงเท่านั้นและไม่ควรถือเป็นคำแนะนำใดๆ ขอคำแนะนำจากผู้เชี่ยวชาญก่อนตัดสินใจลงทุนเสมอ

เกี่ยวกับ เกต เวนเจอร์

Gate Ventures เป็นบริษัทร่วมลงทุนของ Gate.io โดยมุ่งเน้นไปที่การลงทุนในโครงสร้างพื้นฐานแบบกระจายอำนาจ ระบบนิเวศ และแอปพลิเคชันที่จะเปลี่ยนโฉมโลกในยุค Web 3.0 Gate Ventures ทำงานร่วมกับผู้นำอุตสาหกรรมระดับโลกเพื่อเพิ่มศักยภาพให้กับทีมและสตาร์ทอัพด้วยความคิดสร้างสรรค์และความสามารถในการกำหนดรูปแบบปฏิสัมพันธ์ของสังคมและการเงินใหม่

เว็บไซต์อย่างเป็นทางการ: https://ventures.gate.io/ Twitter: https://x.com/gate_ventures สื่อ: https://medium.com/gate_ventures