ในปีที่ผ่านมา การเล่าเรื่องด้วย AI กำลังเฟื่องฟูในตลาด Crypto โดย VC ชั้นนำ เช่น a16z, Sequoia, Lightspeed และ Polychain ลงทุนนับสิบล้านดอลลาร์ในการเดิมพัน ทีมคุณภาพสูงจำนวนมากที่มีพื้นฐานการวิจัยทางวิทยาศาสตร์และภูมิหลังของโรงเรียนที่มีชื่อเสียงได้เข้าสู่ Web3 และกำลังก้าวไปสู่ AI แบบกระจายอำนาจ ในอีก 12 เดือนข้างหน้า เราจะได้เห็นการดำเนินโครงการคุณภาพสูงเหล่านี้อย่างค่อยเป็นค่อยไป

ในเดือนตุลาคมของปีนี้ OpenAI ระดมทุนได้อีก 6.6 พันล้านดอลลาร์สหรัฐ และการแข่งขันด้านอาวุธในเส้นทาง AI ก็สูงถึงประวัติการณ์ นักลงทุนรายย่อยแทบไม่มีโอกาสสร้างรายได้นอกเหนือจากการลงทุนโดยตรงใน Nvidia และฮาร์ดแวร์ ความกระตือรือร้นนี้ยังคงแพร่กระจายไปยัง Crypto โดยเฉพาะคลื่นลูกล่าสุดที่ผู้คนจับสุนัขที่ขับเคลื่อนโดย AI Meme คาดการณ์ได้ว่า Crypto x AI ไม่ว่าจะเป็นโทเค็นที่มีอยู่หรือโครงการดาวดวงใหม่ จะยังคงได้รับแรงผลักดันที่แข็งแกร่ง

เนื่องจากโครงการชั้นนำด้าน AI แบบกระจายอำนาจ ซึ่ง Hyperbolic เพิ่งได้รับการลงทุนครั้งที่สองจาก Polychain และ Lightspeed เราจะเริ่มจาก 6 โครงการที่เพิ่งได้รับเงินทุนจำนวนมากจากสถาบันชั้นนำ จัดเรียงบริบทการพัฒนาของโครงการโครงสร้างพื้นฐาน Crypto x AI และ ตั้งตารอการกระจายอำนาจว่าเทคโนโลยีจะปกป้องมนุษย์ได้อย่างไรในอนาคตของ AI

เมื่อเร็ว ๆ นี้ได้ประกาศเสร็จสิ้นการจัดหาเงินทุน Series A มูลค่า 12 ล้านเหรียญสหรัฐ ซึ่งนำโดย Variant และ Polychain จำนวนเงินทุนรวมเกินกว่า 20 ล้านเหรียญสหรัฐ Bankless Ventures, Chapter One, Lightspeed Faction, IOSG, Blockchain Builders Fund, Alumni Ventures, Samsung Next และอื่น ๆ การมีส่วนร่วมของ VC ที่มีชื่อเสียง

PIN AI: เสร็จสิ้นการจัดหาเงินทุนรอบล่วงหน้ามูลค่า 10 ล้านดอลลาร์ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น a16z CSX, Hack VC และ Blockchain Builders Fund (Stanford Blockchain Accelerator)

Vana: เสร็จสิ้นการจัดหาเงินทุน Series A มูลค่า 18 ล้านเหรียญสหรัฐ และการจัดหาเงินทุนเชิงกลยุทธ์ 5 ล้านเหรียญสหรัฐ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น Paradigm, Polychain และ Coinbase

Sahara: เสร็จสิ้นการจัดหาเงินทุน Series A มูลค่า 43 ล้านเหรียญสหรัฐ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น Binance Labs, Pantera Capital และ Polychain

Aethir: ดำเนินการจัดหาเงินทุนรอบ Pre-A มูลค่า 9 ล้านดอลลาร์ในปี 2566 ด้วยมูลค่า 150 ล้านดอลลาร์ และทำยอดขายโหนดให้เสร็จสิ้นประมาณ 120 ล้านดอลลาร์ในปี 2567

IO.NET: เสร็จสิ้นการระดมทุน Series A มูลค่า 30 ล้านดอลลาร์สหรัฐ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น Hack VC, Delphi Digital และ Foresight Ventures

องค์ประกอบสามประการของ AI: ข้อมูล พลังการประมวลผล และอัลกอริธึม

มาร์กซ์บอกเราใน "Das Kapital" ว่าปัจจัยการผลิต ผลผลิต และความสัมพันธ์ในการผลิตเป็นองค์ประกอบสำคัญในการผลิตทางสังคม หากเราเปรียบเทียบเราจะพบว่ามีองค์ประกอบสำคัญสามประการในโลกปัญญาประดิษฐ์

ในยุค AI พลังการประมวลผล ข้อมูล และอัลกอริธึมถือเป็นกุญแจสำคัญ

ใน AI ข้อมูลคือปัจจัยการผลิต ตัวอย่างเช่น คุณพิมพ์และแชทบนโทรศัพท์มือถือของคุณทุกวัน ถ่ายรูปและโพสต์ลงใน Moments ข้อความและรูปภาพเหล่านี้ล้วนเป็นข้อมูลทั้งสิ้น

ข้อมูลนี้มีตั้งแต่ข้อมูลตัวเลขที่มีโครงสร้างไปจนถึงรูปภาพ เสียง วิดีโอ และข้อความที่ไม่มีโครงสร้าง หากไม่มีข้อมูล อัลกอริธึม AI จะไม่สามารถเรียนรู้และปรับให้เหมาะสมได้ คุณภาพ ปริมาณ ความครอบคลุม และความหลากหลายของข้อมูลส่งผลโดยตรงต่อประสิทธิภาพของโมเดล AI และเป็นตัวกำหนดว่าจะสามารถทำงานเฉพาะอย่างได้อย่างมีประสิทธิภาพหรือไม่

ใน AI พลังการประมวลผลคือประสิทธิภาพการทำงาน พลังการประมวลผลเป็นทรัพยากรการประมวลผลที่จำเป็นต่อการดำเนินการอัลกอริธึม AI ยิ่งพลังการประมวลผลแข็งแกร่งเท่าไร ความเร็วการประมวลผลข้อมูลก็จะเร็วขึ้นและดีขึ้นเท่านั้น จุดแข็งของพลังการประมวลผลเป็นตัวกำหนดประสิทธิภาพและความสามารถของระบบ AI โดยตรง

พลังการประมวลผลอันทรงพลังไม่เพียงแต่ช่วยลดระยะเวลาการฝึกอบรมของโมเดลเท่านั้น แต่ยังสนับสนุนสถาปัตยกรรมโมเดลที่ซับซ้อนมากขึ้น ซึ่งจะช่วยปรับปรุงระดับความฉลาดของ AI อีกด้วย โมเดลภาษาขนาดใหญ่ เช่น ChatGPT ของ OpenAI ใช้เวลาหลายเดือนในการฝึกอบรมบนคลัสเตอร์การประมวลผลอันทรงพลัง

ใน AI อัลกอริธึมคือความสัมพันธ์ในการผลิต อัลกอริธึมเป็นหัวใจสำคัญของ AI การออกแบบจะกำหนดว่าข้อมูลและพลังการประมวลผลทำงานร่วมกันอย่างไร และเป็นกุญแจสำคัญในการแปลงข้อมูลให้เป็นการตัดสินใจที่ชาญฉลาด ด้วยการสนับสนุนของพลังการประมวลผลอันทรงพลัง อัลกอริธึมสามารถเรียนรู้รูปแบบในข้อมูลได้ดีขึ้นและนำไปใช้กับปัญหาในทางปฏิบัติ

จากมุมมองนี้ ข้อมูลเทียบเท่ากับเชื้อเพลิงของ AI พลังการประมวลผลคือกลไกของ AI และอัลกอริธึมคือจิตวิญญาณของ AI AI = ข้อมูล + พลังการประมวลผล + อัลกอริธึม สตาร์ทอัพใด ๆ ที่ต้องการโดดเด่นในเส้นทาง AI จะต้องมีองค์ประกอบทั้งสามอย่างหรือแสดงความเป็นผู้นำที่เป็นเอกลักษณ์ในองค์ประกอบใดองค์ประกอบหนึ่ง

เนื่องจาก AI กำลังพัฒนาไปสู่รูปแบบที่หลากหลาย (โมเดลจะขึ้นอยู่กับข้อมูลหลายรูปแบบและสามารถประมวลผลข้อความ รูปภาพ เสียง ฯลฯ ได้พร้อมกัน) ความต้องการพลังการประมวลผลและข้อมูลจะเพิ่มขึ้นแบบทวีคูณเท่านั้น

ในยุคของพลังการประมวลผลที่หายาก Crypto เสริมพลังให้กับ AI

การเกิดขึ้นของ ChatGPT ไม่เพียงแต่ทำให้เกิดการปฏิวัติปัญญาประดิษฐ์เท่านั้น แต่ยังผลักดันพลังการประมวลผลและฮาร์ดแวร์การประมวลผลไปสู่แถวหน้าของการค้นหาเทคโนโลยีโดยไม่ได้ตั้งใจอีกด้วย

หลังจาก "Thousand Model War" ในปี 2566 และในปี 2567 เนื่องจากความเข้าใจของตลาดเกี่ยวกับโมเดลขนาดใหญ่ของ AI ยังคงลึกซึ้งยิ่งขึ้น การแข่งขันระดับโลกเกี่ยวกับโมเดลขนาดใหญ่จึงถูกแบ่งออกเป็นสองเส้นทาง ได้แก่ "การปรับปรุงขีดความสามารถ" และ "การพัฒนาสถานการณ์"

ในแง่ของการปรับปรุงความสามารถของโมเดลขนาดใหญ่ ความคาดหวังที่ยิ่งใหญ่ที่สุดของตลาดคือ GPT-5 ซึ่งมีข่าวลือว่าจะเปิดตัวโดย OpenAI ในปีนี้ เป็นที่คาดหวังอย่างกระตือรือร้นว่าโมเดลขนาดใหญ่จะถูกผลักดันไปสู่ขั้นตอนหลายรูปแบบอย่างแท้จริง

ในแง่ของการพัฒนาฉากโมเดลขนาดใหญ่ AI ยักษ์ใหญ่กำลังส่งเสริมการบูรณาการโมเดลขนาดใหญ่เข้ากับสถานการณ์อุตสาหกรรมได้เร็วขึ้น เพื่อสร้างมูลค่าแอปพลิเคชัน ตัวอย่างเช่น ความพยายามใน AI Agent, การค้นหา AI และสาขาอื่นๆ กำลังปรับปรุงประสบการณ์ผู้ใช้ที่มีอยู่ให้ลึกซึ้งยิ่งขึ้นอย่างต่อเนื่องโดยใช้โมเดลขนาดใหญ่

เบื้องหลังทั้งสองเส้นทางนี้ มีความต้องการพลังการประมวลผลที่สูงขึ้นอย่างไม่ต้องสงสัย การปรับปรุงความสามารถของโมเดลขนาดใหญ่นั้นขึ้นอยู่กับการฝึกอบรมเป็นหลัก ซึ่งต้องใช้พลังการประมวลผลประสิทธิภาพสูงมหาศาลในระยะเวลาอันสั้น การประยุกต์ใช้สถานการณ์จำลองขนาดใหญ่นั้นขึ้นอยู่กับการอนุมานเป็นหลัก และข้อกำหนดด้านประสิทธิภาพสำหรับพลังการประมวลผลค่อนข้างต่ำ แต่เน้นที่ความเสถียรและชั่วโมงแฝงที่ต่ำมากกว่า

ตามที่ OpenAI คาดการณ์ไว้ในปี 2018 ตั้งแต่ปี 2012 พลังการประมวลผลที่จำเป็นในการฝึกโมเดลขนาดใหญ่เพิ่มขึ้นสองเท่าทุกๆ 3.5 เดือน และพลังการประมวลผลที่ต้องการก็เพิ่มขึ้นมากถึง 10 เท่าทุกปี ในขณะเดียวกัน เนื่องจากโมเดลและแอปพลิเคชันขนาดใหญ่ถูกนำไปใช้ในสถานการณ์ทางธุรกิจจริงขององค์กรมากขึ้น ความต้องการพลังการประมวลผลเชิงอนุมานก็เพิ่มขึ้นเช่นกัน

ปัญหาคือความต้องการ GPU ประสิทธิภาพสูงกำลังเติบโตอย่างรวดเร็วทั่วโลก แต่อุปทานกลับไม่สามารถตามทันได้ ยกตัวอย่างชิป H100 ของ NVIDIA โดยประสบปัญหาการขาดแคลนอุปทานอย่างรุนแรงในปี 2023 โดยมีช่องว่างอุปทานมากกว่า 430,000 หน่วย ชิป B 100 ที่กำลังจะมาถึงซึ่งมีประสิทธิภาพดีขึ้น 2.5 เท่าและมีราคาสูงกว่าเพียง 25% มีแนวโน้มว่าจะขาดแคลนอุปทานอีกครั้ง ความไม่สมดุลระหว่างอุปสงค์และอุปทานจะทำให้ต้นทุนของพลังการประมวลผลเพิ่มขึ้นอีกครั้ง ทำให้เป็นเรื่องยากสำหรับองค์กรขนาดเล็กและขนาดกลางจำนวนมากที่จะจ่ายต้นทุนการประมวลผลที่สูง ซึ่งจำกัดศักยภาพในการพัฒนาในด้าน AI

บริษัทเทคโนโลยีขนาดใหญ่ เช่น OpenAI, Google และ Meta มีความสามารถในการจัดหาทรัพยากรที่แข็งแกร่งขึ้น และมีเงินและทรัพยากรสำหรับสร้างโครงสร้างพื้นฐานการประมวลผลของตนเอง แต่แล้วสตาร์ทอัพด้าน AI ล่ะ นับประสาอะไรกับสตาร์ทอัพที่ยังไม่ได้ระดมทุนล่ะ?

แท้จริงแล้วการซื้อ GPU มือสองบน eBay, Amazon และแพลตฟอร์มอื่นๆ ก็เป็นวิธีที่เป็นไปได้เช่นกัน แม้ว่าต้นทุนจะลดลง แต่ก็อาจเกิดปัญหาด้านประสิทธิภาพและค่าซ่อมในระยะยาว ในยุคที่ GPU ขาดแคลนเช่นนี้ การสร้างโครงสร้างพื้นฐานอาจไม่ใช่ทางออกที่ดีที่สุดสำหรับสตาร์ทอัพ

แม้ว่าจะมีผู้ให้บริการคลาวด์ GPU ที่สามารถเช่าได้ตามความต้องการ แต่ราคาที่สูงก็ถือเป็นความท้าทายที่ยิ่งใหญ่สำหรับพวกเขาเช่นกัน ตัวอย่างเช่น ราคาของ NVIDIA A 100 อยู่ที่ประมาณ 80 เหรียญสหรัฐต่อวัน หากจำเป็นต้องใช้ GPU 50 ตัวในการทำงานทุกครั้ง เดือน เป็นเวลา 25 วัน ค่าใช้จ่ายในแง่ของพลังการประมวลผลเพียงอย่างเดียวจะสูงถึง 80 x 50 x 25 = 100,000 ดอลลาร์สหรัฐต่อเดือน

สิ่งนี้ทำให้เครือข่ายพลังการประมวลผลแบบกระจายอำนาจที่ใช้ DePIN มีโอกาสที่จะใช้ประโยชน์จากสถานการณ์ และอาจกล่าวได้ว่าเป็นไปอย่างราบรื่น เช่นเดียวกับที่ IO.NET, Aethir และ Hyperbolic ทำ พวกเขาเปลี่ยนต้นทุนโครงสร้างพื้นฐานการประมวลผลของสตาร์ทอัพ AI ไปที่เครือข่าย และช่วยให้ทุกคนทั่วโลกสามารถเชื่อมต่อ GPU ที่ไม่ได้ใช้ที่บ้านเข้ากับ GPU ได้ ซึ่งช่วยลดค่าใช้จ่ายในการประมวลผลได้อย่างมาก

Aethir: เครือข่ายการแบ่งปัน GPU ระดับโลก ทำให้พลังการประมวลผลเป็นสากล

Aethir เสร็จสิ้นการจัดหาเงินทุนรอบ Pre-A มูลค่า 9 ล้านดอลลาร์ในเดือนกันยายน 2566 ด้วยมูลค่า 150 ล้านดอลลาร์ และเสร็จสิ้นการขายโหนด Checker Node ที่ประมาณ 120 ล้านดอลลาร์ตั้งแต่เดือนมีนาคมถึงพฤษภาคมปีนี้ Aethir มีรายได้ 60 ล้านดอลลาร์จากการขาย Checker Node ในเวลาเพียง 30 นาที ซึ่งแสดงให้เห็นถึงการยอมรับและความคาดหวังของตลาดสำหรับโปรเจ็กต์นี้

หัวใจสำคัญของ Aethir คือการสร้างเครือข่าย GPU แบบกระจายอำนาจ เพื่อให้ทุกคนมีโอกาสสนับสนุนทรัพยากร GPU ที่ไม่ได้ใช้งานและรับผลกำไร เหมือนกับการเปลี่ยนคอมพิวเตอร์ของทุกคนให้เป็นซูเปอร์คอมพิวเตอร์ขนาดเล็ก ที่ทุกคนแบ่งปันพลังการประมวลผลร่วมกัน ข้อดีของสิ่งนี้คือสามารถปรับปรุงการใช้งาน GPU ได้อย่างมาก และลดการสิ้นเปลืองทรัพยากร นอกจากนี้ยังช่วยให้บริษัทหรือบุคคลที่ต้องการพลังการประมวลผลจำนวนมากได้รับทรัพยากรที่จำเป็นด้วยต้นทุนที่ต่ำลง

Aethir ได้สร้างเครือข่าย DePIN แบบกระจายอำนาจที่ทำหน้าที่เหมือนกับแหล่งรวมทรัพยากร จูงใจให้ศูนย์ข้อมูล สตูดิโอเกม บริษัทเทคโนโลยี และนักเล่นเกมจากทั่วโลกเชื่อมต่อ GPU ที่ไม่ได้ใช้งานเข้ากับเครือข่าย ผู้ให้บริการ GPU เหล่านี้มีอิสระในการเข้าและออกจากเครือข่ายของ GPU ดังนั้นจึงมีการใช้งานที่สูงกว่าการไม่ได้ใช้งาน สิ่งนี้ทำให้ Aethir สามารถจัดหาทรัพยากร GPU ระดับผู้บริโภค ระดับมืออาชีพ และระดับศูนย์ข้อมูลให้กับผู้ต้องการพลังงานในการประมวลผลในราคาที่ต่ำกว่าผู้ให้บริการคลาวด์ Web2 มากกว่า 80%

สถาปัตยกรรม DePIN ของ Aethir รับประกันคุณภาพและความเสถียรของพลังการประมวลผลที่กระจัดกระจายเหล่านี้ ส่วนหลักสามส่วนที่สุดคือ:

Container เป็นหน่วยประมวลผลของ Aethir ซึ่งทำหน้าที่เป็นเซิร์ฟเวอร์คลาวด์และรับผิดชอบในการรันและเรนเดอร์แอปพลิเคชัน แต่ละงานถูกห่อหุ้มไว้ในคอนเทนเนอร์ที่แยกจากกันเป็นสภาพแวดล้อมที่ค่อนข้างโดดเดี่ยวเพื่อรันงานของลูกค้า โดยหลีกเลี่ยงการรบกวนซึ่งกันและกันระหว่างงานต่างๆ

Indexer ส่วนใหญ่จะใช้เพื่อจับคู่และกำหนดเวลาทรัพยากรคอมพิวเตอร์ที่มีอยู่ทันทีตามความต้องการของงาน ในเวลาเดียวกัน กลไกการปรับทรัพยากรแบบไดนามิกสามารถจัดสรรทรัพยากรแบบไดนามิกให้กับงานต่างๆ ตามโหลดของเครือข่ายทั้งหมด เพื่อให้บรรลุประสิทธิภาพโดยรวมที่ดีที่สุด

Checker มีหน้าที่ตรวจสอบและประเมินประสิทธิภาพของคอนเทนเนอร์แบบเรียลไทม์ สามารถตรวจสอบและประเมินสถานะของเครือข่ายทั้งหมดแบบเรียลไทม์ และตอบสนองต่อปัญหาด้านความปลอดภัยที่อาจเกิดขึ้นได้ทันท่วงที หากคุณต้องการตอบสนองต่อเหตุการณ์ด้านความปลอดภัย เช่น การโจมตีเครือข่าย หลังจากตรวจพบพฤติกรรมที่ผิดปกติ คุณสามารถออกคำเตือนและเริ่มมาตรการป้องกันได้ทันที ในทำนองเดียวกัน เมื่อเกิดปัญหาคอขวดของประสิทธิภาพเครือข่าย Checker ยังสามารถส่งการแจ้งเตือนตามเวลาเพื่อให้สามารถแก้ไขปัญหาได้ทันที เพื่อให้มั่นใจในคุณภาพและความปลอดภัยของบริการ

การทำงานร่วมกันที่มีประสิทธิภาพระหว่าง Container, Indexer และ Checker ช่วยให้ลูกค้าได้รับการกำหนดค่าพลังการประมวลผลที่ปรับแต่งได้อย่างอิสระ ประสบการณ์บริการคลาวด์ที่ปลอดภัย เสถียร และมีราคาค่อนข้างต่ำ Aethir เป็นโซลูชันระดับเชิงพาณิชย์ที่ดีสำหรับด้านต่างๆ เช่น AI และเกม

โดยทั่วไป Aethir ปรับโฉมการจัดสรรและการใช้ทรัพยากร GPU ผ่าน DePIN ทำให้พลังการประมวลผลเป็นที่นิยมและประหยัดมากขึ้น บริษัทได้รับผลลัพธ์ที่ดีในด้าน AI และเกม และกำลังขยายพันธมิตรและสายธุรกิจอย่างต่อเนื่อง ศักยภาพในการพัฒนาในอนาคตนั้นไร้ขีดจำกัด

IO.NET: เครือข่ายซูเปอร์คอมพิวเตอร์แบบกระจายที่ทำลายคอขวดของพลังการประมวลผล

IO.NET เสร็จสิ้นการระดมทุน Series A มูลค่า 30 ล้านดอลลาร์ในเดือนมีนาคมปีนี้ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น Hack VC, Delphi Digital และ Foresight Ventures

เช่นเดียวกับ Aethir สร้างเครือข่ายการประมวลผลแบบกระจายอำนาจระดับองค์กรเพื่อมอบบริการคอมพิวเตอร์ที่มีราคาต่ำกว่า ง่ายต่อการรับ และปรับเปลี่ยนได้อย่างยืดหยุ่นมากขึ้นแก่สตาร์ทอัพ AI ด้วยการรวบรวมทรัพยากรการประมวลผลที่ไม่ได้ใช้งาน (GPU, CPU) ทั่วโลก

ต่างจาก Aethir ตรงที่ IO.NET ใช้เฟรมเวิร์ก Ray (IO-SDK) เพื่อแปลงคลัสเตอร์ GPU นับพันเป็นกลุ่มเพื่อรองรับการเรียนรู้ของเครื่อง (OpenAI เฟรมเวิร์กยังใช้เฟรมเวิร์ก Ray เพื่อฝึก GPT-3) ข้อจำกัดของหน่วยความจำ CPU/GPU และเวิร์กโฟลว์การประมวลผลตามลำดับทำให้เกิดปัญหาคอขวดที่สำคัญเมื่อฝึกโมเดลขนาดใหญ่บนอุปกรณ์เครื่องเดียว กรอบงาน Ray ใช้สำหรับการเรียบเรียงและการประมวลผลเป็นชุดเพื่อให้บรรลุงานการประมวลผลแบบขนาน

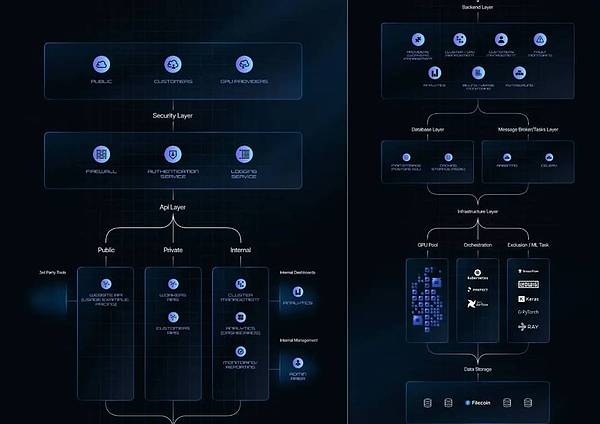

ในการดำเนินการนี้ IO.NET จะใช้สถาปัตยกรรมหลายชั้น:

เลเยอร์ส่วนต่อประสานกับผู้ใช้: มอบส่วนต่อประสานส่วนหน้าแบบเห็นภาพแก่ผู้ใช้ รวมถึงเว็บไซต์สาธารณะ พื้นที่ลูกค้า และพื้นที่ซัพพลายเออร์ GPU โดยมีเป้าหมายเพื่อมอบประสบการณ์ผู้ใช้ที่ใช้งานง่ายและเป็นมิตร

ชั้นความปลอดภัย: รับประกันความสมบูรณ์และความปลอดภัยของระบบ บูรณาการการป้องกันเครือข่าย การตรวจสอบผู้ใช้ การบันทึกกิจกรรม และกลไกอื่น ๆ

เลเยอร์ API: ในฐานะศูนย์กลางการสื่อสารสำหรับเว็บไซต์ ซัพพลายเออร์ และการจัดการภายใน อำนวยความสะดวกในการแลกเปลี่ยนข้อมูลและการดำเนินการต่างๆ

เลเยอร์แบ็คเอนด์: เป็นแกนหลักของระบบและรับผิดชอบงานปฏิบัติการ เช่น การจัดการคลัสเตอร์/GPU การโต้ตอบกับลูกค้า และการขยายอัตโนมัติ

ชั้นฐานข้อมูล: รับผิดชอบการจัดเก็บและการจัดการข้อมูล พื้นที่จัดเก็บข้อมูลหลักรับผิดชอบข้อมูลที่มีโครงสร้าง และแคชใช้สำหรับการประมวลผลข้อมูลชั่วคราว

ชั้นงาน: จัดการการสื่อสารแบบอะซิงโครนัสและการดำเนินงานเพื่อให้มั่นใจถึงประสิทธิภาพของการประมวลผลและการหมุนเวียนข้อมูล

เลเยอร์โครงสร้างพื้นฐาน: สร้างพื้นฐานของระบบ รวมถึงพูลทรัพยากร GPU เครื่องมือจัดระเบียบ และงานการดำเนินการ/ML และมาพร้อมกับโซลูชันการตรวจสอบที่ทรงพลัง

จากมุมมองทางเทคนิค เพื่อที่จะแก้ปัญหาที่ต้องเผชิญกับพลังการประมวลผลแบบกระจาย IO.NET ได้เปิดตัวสถาปัตยกรรมแบบเลเยอร์ของเทคโนโลยีหลัก IO-SDK เช่นเดียวกับเทคโนโลยี Reverse Tunnel และสถาปัตยกรรม Mesh VPN เพื่อแก้ไขการเชื่อมต่อที่ปลอดภัยและ ปัญหาความเป็นส่วนตัวของข้อมูล ได้รับความนิยมใน Web3 และถูกเรียกว่า Filecoin ตัวถัดไป พร้อมอนาคตที่สดใส

โดยทั่วไป ภารกิจหลักของ IO.NET คือการสร้างโครงสร้างพื้นฐาน DePIN ที่ใหญ่ที่สุดในโลก รวบรวมทรัพยากร GPU ที่ไม่ได้ใช้งานทั่วโลก และให้การสนับสนุนด้าน AI และการเรียนรู้ของเครื่องที่ต้องใช้พลังการประมวลผลจำนวนมาก

ไฮเปอร์โบลิก: สร้าง “ป่าฝน AI” เพื่อตระหนักถึงระบบนิเวศโครงสร้างพื้นฐาน AI แบบกระจายที่เจริญรุ่งเรืองและสนับสนุนร่วมกัน

วันนี้ Hyperbolic ได้ประกาศอีกครั้งว่าได้เสร็จสิ้นการระดมทุน Series A มูลค่ารวมกว่า 12 ล้านเหรียญสหรัฐ ซึ่งนำโดย Variant และ Polychain Capital ส่งผลให้ยอดการจัดหาเงินทุนรวมมากกว่า 20 ล้านเหรียญสหรัฐ Bankless Ventures, Chapter One, Lightspeed Faction, IOSG, Blockchain Builders Fund, Alumni Ventures, Samsung Next และสถาบัน VC ที่มีชื่อเสียงอื่น ๆ เข้าร่วมในการลงทุน ในหมู่พวกเขา Polychain และ LightSpeed Faction ซึ่งเป็นเมืองหลวงร่วมทุนชั้นนำของ Silicon Valley ได้เพิ่มการลงทุนเป็นครั้งที่สองหลังจากรอบ Seed ซึ่งเพียงพอที่จะแสดงให้เห็นถึงตำแหน่งผู้นำของ Hyperbolic ในเส้นทาง Web3 AI

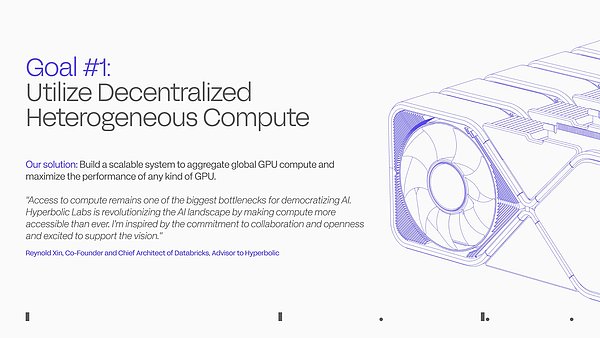

ภารกิจหลักของไฮเปอร์โบลิกคือการทำให้ AI พร้อมใช้งานสำหรับทุกคน ราคาไม่แพงสำหรับนักพัฒนา และราคาไม่แพงสำหรับผู้สร้าง ไฮเปอร์โบลิกมีเป้าหมายเพื่อสร้าง "ป่าฝน AI" ซึ่งนักพัฒนาสามารถค้นหาทรัพยากรที่จำเป็นในการสร้างสรรค์ ทำงานร่วมกัน และเติบโตภายในระบบนิเวศของตน เช่นเดียวกับป่าฝนธรรมชาติ ระบบนิเวศเชื่อมโยงถึงกัน มีชีวิตชีวา และหมุนเวียนได้ ทำให้ผู้สร้างสามารถสำรวจได้ไม่จำกัด

ในมุมมองของผู้ร่วมก่อตั้งทั้งสอง Jasper และ Yuchen แม้ว่าโมเดล AI จะสามารถเป็นโอเพ่นซอร์สได้ แต่ก็ไม่เพียงพอหากไม่มีทรัพยากรคอมพิวเตอร์แบบเปิด ปัจจุบันศูนย์ข้อมูลขนาดใหญ่หลายแห่งควบคุมทรัพยากร GPU ซึ่งทำให้หลายคนไม่ต้องการใช้ AI ท้อใจ ไฮเปอร์โบลิกมีเป้าหมายที่จะทำลายสถานการณ์นี้ พวกเขาสร้างโครงสร้างพื้นฐานการประมวลผล DePIN โดยการบูรณาการทรัพยากรการประมวลผลที่ไม่ได้ใช้งานทั่วโลก เพื่อให้ทุกคนสามารถใช้ AI ได้อย่างง่ายดาย

ดังนั้น ไฮเปอร์โบลิกจึงได้นำเสนอแนวคิดของ "คลาวด์ AI แบบเปิด" ทุกอย่างตั้งแต่คอมพิวเตอร์ส่วนบุคคลไปจนถึงศูนย์ข้อมูลขนาดใหญ่สามารถเชื่อมต่อกับไฮเปอร์โบลิกเพื่อมอบพลังการประมวลผล บนพื้นฐานนี้ ไฮเปอร์โบลิกจะสร้างเลเยอร์ AI ที่ปรับปรุงความเป็นส่วนตัวที่ตรวจสอบได้ ซึ่งช่วยให้นักพัฒนาสามารถสร้างแอปพลิเคชัน AI ที่มีความสามารถในการให้เหตุผล ในขณะที่พลังการประมวลผลที่ต้องการนั้นมาจากคลาวด์ AI โดยตรง

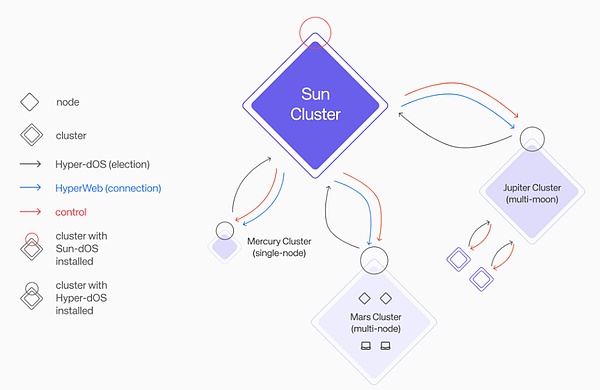

เช่นเดียวกับ Aethir และ IO.NET คลาวด์ AI ของ Hyperbolic มีโมเดลคลัสเตอร์ GPU ที่เป็นเอกลักษณ์ของตัวเอง ซึ่งเรียกว่า "Solar System Cluster" ดังที่เราทราบ ระบบสุริยะประกอบด้วยดาวเคราะห์อิสระหลายดวง เช่น ดาวพุธและดาวอังคาร กระจุกดาวในระบบสุริยะของไฮเปอร์โบลิกจัดการ เช่น กระจุกดาวพุธ กระจุกดาวพฤหัสบดี และกระจุกดาวพฤหัสบดี มีการใช้กันอย่างแพร่หลายและมีขนาดแตกต่างกัน แต่เป็นอิสระจากกัน

โมเดลดังกล่าวช่วยให้มั่นใจได้ว่าคลัสเตอร์ GPU มีคุณสมบัติตรงตามสองคุณลักษณะ มีความยืดหยุ่นมากกว่า และเพิ่มประสิทธิภาพสูงสุดเมื่อเทียบกับ Aethir และ IO.NET :

ปรับสมดุลสถานะ จากนั้นคลัสเตอร์ GPU จะขยายหรือย่อโดยอัตโนมัติตามความต้องการ

หากคลัสเตอร์ถูกขัดจังหวะ คลัสเตอร์ Solar System จะตรวจจับและซ่อมแซมโดยอัตโนมัติ

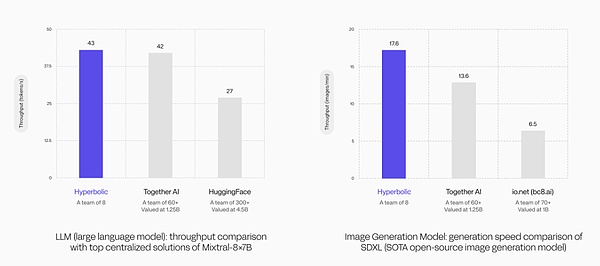

ในการทดลองเปรียบเทียบประสิทธิภาพของโมเดลภาษาขนาดใหญ่ (LLM) ปริมาณงานของคลัสเตอร์ Hyperbolic GPU สูงถึง 43 โทเค็น/วินาที ผลลัพธ์นี้ไม่เพียงแต่เกิน 42 โทเค็น/วินาทีของทีม Together AI 60 คนเท่านั้น แต่ยังเป็นอีกด้วย ยังสูงกว่า 27 โทเค็น/วินาทีอย่างมากสำหรับ HuggingFace ซึ่งมีสมาชิกในทีมมากกว่า 300 คน

ในการทดลองเปรียบเทียบความเร็วในการสร้างโมเดลการสร้างภาพ คลัสเตอร์ Hyperbolic GPU ยังแสดงให้เห็นว่าไม่ควรประเมินความแข็งแกร่งทางเทคนิคต่ำเกินไป นอกจากนี้ การใช้โมเดลการสร้างอิมเมจแบบโอเพ่นซอร์ส SOTA ทำให้ไฮเปอร์โบลิกลีดมีความเร็วการสร้าง 17.6 ภาพ/นาที ซึ่งไม่เพียงแต่เกินกว่า Together AI ที่ 13.6 ภาพ/นาที แต่ยังสูงกว่า 6.5 ภาพ/นาทีของ IO.NET อีกด้วย

ข้อมูลเหล่านี้พิสูจน์ให้เห็นอย่างชัดเจนว่าโมเดลคลัสเตอร์ GPU ของ Hyperbolic มีประสิทธิภาพสูงมาก และประสิทธิภาพที่ยอดเยี่ยมทำให้โดดเด่นเหนือคู่แข่งรายใหญ่ เมื่อรวมกับข้อได้เปรียบด้านราคาที่ต่ำ ทำให้ Hyperbolic เหมาะอย่างยิ่งสำหรับแอปพลิเคชัน AI ที่ซับซ้อนซึ่งต้องการการรองรับพลังการประมวลผลสูง ให้การตอบสนองที่ใกล้เคียงเรียลไทม์ และมั่นใจได้ว่าโมเดล AI มีความแม่นยำและประสิทธิภาพสูงกว่าเมื่อจัดการงานที่ซับซ้อน

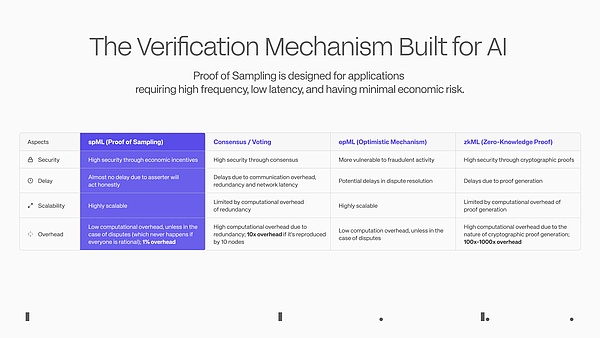

นอกจากนี้ จากมุมมองของนวัตกรรมการเข้ารหัส เราเชื่อว่าความสำเร็จที่โดดเด่นที่สุดของ Hyperbolic คือการพัฒนากลไกการตรวจสอบ PoSP (Proof of Sampling, Sampling Proof) ซึ่งใช้วิธีการกระจายอำนาจเพื่อแก้ไขหนึ่งในความท้าทายที่ยากที่สุดใน AI ฟิลด์ - ตรวจสอบว่าเอาต์พุตจากโมเดลที่ระบุช่วยให้กระบวนการอนุมานมีการกระจายอำนาจอย่างคุ้มค่าหรือไม่

ตามหลักการ PoSP ทีมไฮเปอร์โบลิกได้พัฒนากลไก spML (การเรียนรู้ของเครื่องตัวอย่าง) สำหรับแอปพลิเคชัน AI การสุ่มตัวอย่างธุรกรรมในเครือข่าย ให้รางวัลแก่ผู้ที่ซื่อสัตย์ และลงโทษผู้ที่ไม่ซื่อสัตย์เพื่อให้บรรลุผลการตรวจสอบที่เบา และลดภาระของการคำนวณ ภาระของเครือข่ายทำให้สตาร์ทอัพ AI เกือบทุกรายกระจายอำนาจบริการ AI ของตนในกระบวนทัศน์การตรวจสอบแบบกระจายได้

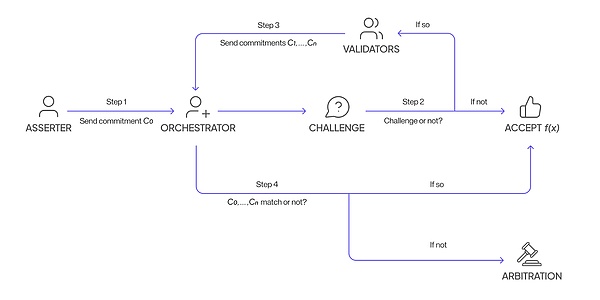

กระบวนการดำเนินการเฉพาะมีดังนี้:

1) โหนดคำนวณฟังก์ชันและส่งผลลัพธ์ไปยังผู้จัดทำในลักษณะที่เข้ารหัส

2) จากนั้นก็ขึ้นอยู่กับผู้จัดทำเพื่อตัดสินใจว่าจะเชื่อถือผลลัพธ์นี้หรือไม่ และหากเป็นเช่นนั้น โหนดจะได้รับรางวัลสำหรับการคำนวณ

3) หากไม่มีความเชื่อถือ Orchestrator จะสุ่มเลือกเครื่องมือตรวจสอบความถูกต้องในเครือข่าย ท้าทายโหนด และคำนวณฟังก์ชันเดียวกัน ในทำนองเดียวกัน ผู้ตรวจสอบจะส่งผลลัพธ์ไปยังผู้จัดทำในลักษณะที่เข้ารหัส

4) ในที่สุด ผู้จัดทำจะตรวจสอบว่าผลลัพธ์ทั้งหมดสอดคล้องกันหรือไม่ ทั้งโหนดและผู้ตรวจสอบจะได้รับรางวัล หากไม่สอดคล้องกัน กระบวนการอนุญาโตตุลาการจะเริ่มขึ้นเพื่อติดตามกระบวนการคำนวณของแต่ละผลลัพธ์ คนซื่อสัตย์จะได้รับรางวัลสำหรับความถูกต้องแม่นยำ ส่วนคนที่ไม่ซื่อสัตย์จะถูกลงโทษฐานโกงระบบ

โหนดไม่ทราบว่าผลลัพธ์ที่พวกเขาส่งมาจะถูกท้าทายหรือไม่ และไม่รู้ว่าผู้ตรวจสอบความถูกต้องคนใดที่ผู้จัดทำจะเลือกท้าทาย เพื่อให้มั่นใจถึงความเป็นธรรมของการตรวจสอบ ค่าใช้จ่ายในการโกงมีมากกว่าผลประโยชน์ที่อาจเกิดขึ้นมาก

หากมีการทดสอบ spML ในอนาคต ก็เพียงพอแล้วที่จะเปลี่ยนกฎของเกมสำหรับแอปพลิเคชัน AI และทำให้การตรวจสอบการอนุมานที่ไร้ความน่าเชื่อถือเป็นจริง นอกจากนี้ ไฮเปอร์โบลิกมีความสามารถเฉพาะตัวในอุตสาหกรรมในการใช้อัลกอริธึม BF 16 ในการใช้เหตุผลแบบจำลอง (คู่แข่งยังคงติดอยู่ที่ FP 8) ซึ่งสามารถปรับปรุงความแม่นยำของการให้เหตุผลได้อย่างมีประสิทธิภาพ ทำให้บริการการให้เหตุผลแบบกระจายอำนาจของไฮเปอร์โบลิกคุ้มค่าอย่างยิ่ง

นอกจากนี้ นวัตกรรมของ Hyperbolic ยังสะท้อนให้เห็นในการบูรณาการแหล่งจ่ายไฟประมวลผลบนคลาวด์ AI และแอปพลิเคชัน AI อีกด้วย ความต้องการตลาดพลังงานการประมวลผลแบบกระจายอำนาจนั้นค่อนข้างหายาก ไฮเปอร์โบลิกดึงดูดนักพัฒนาให้สร้างแอปพลิเคชัน AI โดยการสร้างโครงสร้างพื้นฐาน AI ที่สามารถตรวจสอบได้ สามารถรวมเข้ากับแอปพลิเคชัน AI ได้โดยตรงและราบรื่นโดยไม่กระทบต่อประสิทธิภาพและความปลอดภัย หลังจากขยายไปสู่ระดับหนึ่ง สามารถพึ่งตนเองได้และบรรลุความสมดุลระหว่างอุปสงค์และอุปทาน

นักพัฒนาสามารถสร้างแอปพลิเคชัน AI ที่เป็นนวัตกรรมใหม่เกี่ยวกับพลังการประมวลผล, Web2 และ Web3 บนไฮเปอร์โบลิก เช่น:

GPU Exchange ซึ่งเป็นแพลตฟอร์มการซื้อขาย GPU ที่สร้างขึ้นบนเครือข่าย GPU (เลเยอร์การประสาน) ทำการค้า "ทรัพยากร GPU" เพื่อการซื้อขายฟรี ทำให้พลังการประมวลผลคุ้มค่ามากขึ้น

IAO หรือการสร้างโทเค็นให้กับ AI Agent ช่วยให้ผู้มีส่วนร่วมได้รับโทเค็น และรายได้ของ AI Agent จะถูกแจกจ่ายให้กับผู้ถือโทเค็น

DAO ที่ขับเคลื่อนด้วย AI คือ DAO ที่ช่วยควบคุมการตัดสินใจและการจัดการทางการเงินผ่านปัญญาประดิษฐ์

GPU Resmaking ช่วยให้ผู้ใช้สามารถเชื่อมต่อ GPU ของตนกับ Hyperbolic แล้วนำไปเดิมพันกับแอปพลิเคชัน AI

โดยรวมแล้ว ไฮเปอร์โบลิกได้สร้างระบบนิเวศ AI แบบเปิดที่ช่วยให้ทุกคนใช้ AI ได้อย่างง่ายดาย ด้วยนวัตกรรมทางเทคโนโลยี ไฮเปอร์โบลิกกำลังทำให้ AI เป็นที่นิยมและเข้าถึงได้มากขึ้น ทำให้อนาคตของ AI เต็มไปด้วยความสามารถในการทำงานร่วมกันและความเข้ากันได้ และส่งเสริมนวัตกรรมการทำงานร่วมกัน

ข้อมูลจะส่งกลับคืนสู่ผู้ใช้และเราเข้าร่วมกับคลื่น AI

ปัจจุบัน ข้อมูลเปรียบเสมือนเหมืองทอง และข้อมูลส่วนบุคคลกำลังถูกยึดและนำไปใช้เชิงพาณิชย์โดยบริษัทยักษ์ใหญ่ด้านเทคโนโลยีโดยไม่คิดค่าใช้จ่าย

ข้อมูลคืออาหารของ AI หากไม่มีข้อมูลคุณภาพสูง แม้แต่อัลกอริธึมขั้นสูงสุดก็ไม่สามารถทำงานได้ ปริมาณ คุณภาพ และความหลากหลายของข้อมูลส่งผลโดยตรงต่อประสิทธิภาพของโมเดล AI

ดังที่เราได้กล่าวไปแล้ว อุตสาหกรรมนี้กำลังรอคอยการเปิดตัว GPT-5 อย่างไรก็ตาม ยังไม่ได้รับการเผยแพร่มาเป็นเวลานานอาจเป็นเพราะปริมาณข้อมูลยังไม่เพียงพอ GPT-3 เพียงอย่างเดียวในขั้นตอนการเผยแพร่กระดาษต้องใช้ปริมาณข้อมูล 2 ล้านล้านโทเค็น คาดว่า GPT-5 จะมีปริมาณข้อมูลถึง 200 ล้านล้านโทเค็น นอกเหนือจากข้อมูลข้อความที่มีอยู่แล้ว ยังจำเป็นต้องมีข้อมูลหลายรูปแบบเพิ่มเติม ซึ่งสามารถนำไปใช้ในการฝึกได้หลังจากทำความสะอาดแล้ว

ในข้อมูลอินเทอร์เน็ตสาธารณะในปัจจุบัน มีตัวอย่างข้อมูลคุณภาพสูงค่อนข้างน้อย สถานการณ์จริงคือโมเดลขนาดใหญ่ทำงานได้ดีมากในการสร้างคำถามและคำตอบในทุกสาขา แต่จะทำงานได้ไม่ดีเมื่อต้องเผชิญกับปัญหาในสาขาวิชาชีพและถึงกับล้มเหลว มีภาพลวงตาว่านางแบบ "พูดไร้สาระ"

เพื่อให้มั่นใจว่าข้อมูลมีความ “สด” ยักษ์ใหญ่ด้าน AI มักจะทำข้อตกลงกับเจ้าของแหล่งข้อมูลขนาดใหญ่ ตัวอย่างเช่น OpenAI ลงนามข้อตกลงมูลค่า 60 ล้านดอลลาร์กับ Reddit

ล่าสุด ซอฟต์แวร์โซเชียลบางตัวเริ่มกำหนดให้ผู้ใช้ต้องลงนามในข้อตกลง โดยกำหนดให้ผู้ใช้ตกลงที่จะอนุญาตเนื้อหาเพื่อใช้ในการฝึกอบรมโมเดล AI ของบุคคลที่สาม อย่างไรก็ตาม ผู้ใช้ยังไม่ได้รับรางวัลใดๆ จากสิ่งนี้ พฤติกรรมนักล่านี้ทำให้เกิดข้อสงสัยต่อสาธารณชนเกี่ยวกับสิทธิในการใช้ข้อมูล

เห็นได้ชัดว่าศักยภาพในการกระจายอำนาจและติดตามได้ของบล็อกเชนนั้นมีความเหมาะสมโดยธรรมชาติในการปรับปรุงภาวะที่กลืนไม่เข้าคายไม่ออกในการรับข้อมูลและทรัพยากร ในขณะเดียวกันก็ให้การควบคุมและความโปร่งใสสำหรับข้อมูลผู้ใช้มากขึ้น และยังสามารถได้รับผลประโยชน์จากการเข้าร่วมในการฝึกอบรมและการเพิ่มประสิทธิภาพของโมเดล AI วิธีใหม่ในการสร้างมูลค่าข้อมูลนี้จะช่วยเพิ่มการมีส่วนร่วมของผู้ใช้อย่างมาก และส่งเสริมความเจริญรุ่งเรืองโดยรวมของระบบนิเวศ

Web3 มีบริษัทบางแห่งที่กำหนดเป้าหมายข้อมูล AI อยู่แล้ว เช่น:

การเก็บข้อมูล: Ocean Protocol, Vana, PIN AI, Sahara ฯลฯ

การประมวลผลข้อมูล: AI สาธารณะ, Lightworks ฯลฯ

สิ่งที่น่าสนใจกว่านั้นคือ Vana, PIN AI และ Saraha ซึ่งทั้งหมดนี้เพิ่งได้รับเงินทุนจำนวนมากและมีนักลงทุนจำนวนมาก ทั้งสองโครงการแยกออกจากสาขาย่อยและรวมการเก็บข้อมูลเข้ากับการพัฒนา AI เพื่อส่งเสริมการใช้งานแอปพลิเคชัน AI

Vana: ผู้ใช้ควบคุมข้อมูล DAO และกลไกการมีส่วนร่วมปรับเปลี่ยนเศรษฐกิจข้อมูล AI

Vana เสร็จสิ้นการระดมทุน 18 ล้านดอลลาร์ในเดือนธันวาคม 2565 และ 5 ล้านดอลลาร์ในการจัดหาเงินทุนเชิงกลยุทธ์ในเดือนกันยายนปีนี้ การลงทุนจาก VC ที่มีชื่อเสียง เช่น Paradigm, Polychain และ Coinbase

แนวคิดหลักของ Vana คือ "ข้อมูลที่ผู้ใช้เป็นเจ้าของ ทำให้ AI ของผู้ใช้เป็นจริง" ในยุคที่ข้อมูลคือราชา Vana ต้องการทำลายการผูกขาดของบริษัทขนาดใหญ่ในด้านข้อมูล และให้ผู้ใช้ควบคุมข้อมูลของตนเองและได้รับประโยชน์จากข้อมูลของตนเอง

Vana เป็นเครือข่ายข้อมูลแบบกระจายอำนาจที่มุ่งเน้นการปกป้องข้อมูลส่วนตัว ทำให้สามารถใช้ข้อมูลของผู้ใช้ได้อย่างยืดหยุ่นเหมือนกับสินทรัพย์ทางการเงิน Vana พยายามที่จะปรับโฉมภูมิทัศน์ของเศรษฐกิจข้อมูล และเปลี่ยนผู้ใช้จากผู้ให้บริการข้อมูลเชิงรับไปเป็นผู้สร้างระบบนิเวศที่มีส่วนร่วมและเป็นประโยชน์ร่วมกัน

เพื่อให้บรรลุวิสัยทัศน์นี้ Vana อนุญาตให้ผู้ใช้รวบรวมและอัปโหลดข้อมูลผ่านข้อมูล DAO จากนั้นตรวจสอบมูลค่าของข้อมูลพร้อมทั้งปกป้องความเป็นส่วนตัวผ่านกลไกการพิสูจน์การมีส่วนร่วม ข้อมูลนี้สามารถใช้สำหรับการฝึกอบรม AI และผู้ใช้จะได้รับสิ่งจูงใจตามคุณภาพของข้อมูลที่พวกเขาอัปโหลด

ในแง่ของการนำไปใช้งาน สถาปัตยกรรมทางเทคนิคของ Vana ประกอบด้วยองค์ประกอบหลัก 5 ประการ ได้แก่ ชั้นการเคลื่อนย้ายข้อมูล ชั้นการเคลื่อนย้ายข้อมูล กลุ่มการเชื่อมต่อสากล การจัดเก็บข้อมูลที่ไม่มีการจัดการ และชั้นแอปพลิเคชันแบบกระจายอำนาจ

Data Liquidity Layer : นี่คือแกนหลักของเครือข่าย Vana ซึ่งสร้างแรงจูงใจ รวบรวม และตรวจสอบข้อมูลอันมีค่าผ่าน Data Liquidity Pool (DLP) DLP เปรียบเสมือนเวอร์ชันข้อมูลของ "แหล่งรวมสภาพคล่อง" แต่ละ DLP เป็นสัญญาอัจฉริยะที่ออกแบบมาเพื่อรวบรวมสินทรัพย์ข้อมูลประเภทเฉพาะ เช่น Reddit, Twitter และข้อมูลโซเชียลมีเดียอื่น ๆ

Data Portability Layer : องค์ประกอบนี้ให้ความสามารถในการพกพาข้อมูลผู้ใช้ ทำให้มั่นใจได้ว่าผู้ใช้สามารถถ่ายโอนและใช้ข้อมูลระหว่างแอปพลิเคชันต่างๆ และโมเดล AI ได้อย่างง่ายดาย

แผนที่นิเวศวิทยาข้อมูล : นี่คือแผนที่ที่ติดตามการไหลของข้อมูลแบบเรียลไทม์ทั่วทั้งระบบนิเวศ เพื่อให้เกิดความโปร่งใส

การจัดเก็บข้อมูลที่ไม่มีการจัดการ : นวัตกรรมของ Vana อยู่ในแนวทางการจัดการข้อมูลที่เป็นเอกลักษณ์ ช่วยให้ผู้ใช้สามารถควบคุมข้อมูลของตนได้อย่างเต็มที่ ข้อมูลดั้งเดิมของผู้ใช้จะไม่ถูกอัพโหลดไปยังเชน แต่ผู้ใช้จะเลือกตำแหน่งที่เก็บข้อมูล เช่น เซิร์ฟเวอร์คลาวด์หรือเซิร์ฟเวอร์ส่วนบุคคล

เลเยอร์แอปพลิเคชันแบบกระจายอำนาจ : จากข้อมูล Vana ได้สร้างระบบนิเวศแอปพลิเคชันแบบเปิด นักพัฒนาสามารถใช้ข้อมูลที่รวบรวมโดย DLP เพื่อสร้างแอปพลิเคชันที่เป็นนวัตกรรมต่างๆ รวมถึงแอปพลิเคชัน AI และผู้ให้ข้อมูลจะได้รับประโยชน์จากแอปพลิเคชันเหล่านี้

ปัจจุบัน Vana ถูกสร้างขึ้นโดยใช้แพลตฟอร์มโซเชียลมีเดีย เช่น ChatGPT, Reddit, LinkedIn และ Twitter รวมถึง DLP ที่เน้นไปที่ AI และข้อมูลการท่องเว็บ เมื่อมี DLP เข้าร่วมมากขึ้นและมีการสร้างแอปพลิเคชันเชิงนวัตกรรมมากขึ้นบนแพลตฟอร์ม Vana ก็มีศักยภาพที่จะทำเช่นนั้น กลายเป็น AI แบบกระจายอำนาจรุ่นต่อไปและโครงสร้างพื้นฐานทางเศรษฐกิจด้านข้อมูล

สิ่งนี้ทำให้เรานึกถึงข่าวล่าสุด เพื่อปรับปรุงความหลากหลายของ LLM Meta กำลังรวบรวมข้อมูลจากผู้ใช้ Facebook และ Instagram ในสหราชอาณาจักร อย่างไรก็ตาม ได้รับการวิพากษ์วิจารณ์ว่าอนุญาตให้ผู้ใช้เลือก "เลือกไม่รับ" แทนที่จะ "เห็นด้วย" . บางทีอาจเป็นตัวเลือกที่ดีกว่าสำหรับ Meta ในการสร้าง DLP สำหรับ Facebook และ Instagram ตามลำดับบน Vana ซึ่งไม่เพียงแต่รับประกันความเป็นส่วนตัวของข้อมูลเท่านั้น แต่ยังสนับสนุนให้ผู้ใช้มีส่วนร่วมกับข้อมูลมากขึ้นอีกด้วย

PIN AI: ผู้ช่วย AI แบบกระจายอำนาจ, AI มือถือเชื่อมต่อข้อมูลและชีวิตประจำวัน

PIN AI เสร็จสิ้นการระดมทุนรอบล่วงหน้ามูลค่า 10 ล้านดอลลาร์ในเดือนกันยายนปีนี้ VC และนักลงทุนเทวดาที่มีชื่อเสียงจำนวนหนึ่ง เช่น a16z CSX, Hack VC และ Blockchain Builders Fund (Stanford Blockchain Accelerator) เข้าร่วมในการลงทุนนี้

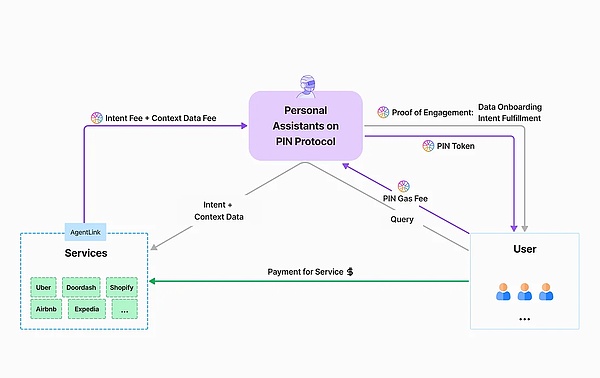

PIN AI เป็นเครือข่าย AI แบบเปิดที่ได้รับการสนับสนุนโดยเครือข่ายจัดเก็บข้อมูลแบบกระจายของสถาปัตยกรรม DePIN ผู้ใช้สามารถเชื่อมต่ออุปกรณ์ของตนกับเครือข่าย ให้ข้อมูลส่วนบุคคล/การตั้งค่าของผู้ใช้ และรับสิ่งจูงใจโทเค็น การย้ายครั้งนี้ทำให้ผู้ใช้สามารถกลับมาควบคุมและสร้างรายได้จากข้อมูลของตนได้ นักพัฒนาสามารถใช้ข้อมูลเพื่อสร้าง AI Agent ที่เป็นประโยชน์ได้

วิสัยทัศน์ของบริษัทคือการเป็นทางเลือกแบบกระจายอำนาจแทน Apple Intelligence โดยมุ่งมั่นที่จะมอบแอปพลิเคชันที่มีประโยชน์ในชีวิตประจำวันแก่กลุ่มผู้ใช้ และตระหนักถึงความตั้งใจของผู้ใช้ เช่น การซื้อสินค้าออนไลน์ การวางแผนการเดินทาง และการวางแผนพฤติกรรมการลงทุน

PIN AI ประกอบด้วย AI สองประเภท ผู้ช่วย AI ส่วนบุคคล และบริการ AI ภายนอก

ผู้ช่วย AI ส่วนบุคคลสามารถเข้าถึงข้อมูลผู้ใช้ รวบรวมความต้องการของผู้ใช้ และให้ข้อมูลที่เหมาะสมแก่บริการภายนอกแก่ AI เมื่อพวกเขาต้องการ ชั้นล่างสุดของ PIN AI ประกอบด้วยเครือข่ายการจัดเก็บข้อมูลแบบกระจาย DePIN ซึ่งให้ข้อมูลผู้ใช้ที่หลากหลายสำหรับการอนุมานบริการ AI ภายนอกโดยไม่ต้องเข้าถึงความเป็นส่วนตัวของผู้ใช้

ด้วย PIN AI ผู้ใช้จะไม่จำเป็นต้องเปิดแอปมือถือนับพันเพื่อทำงานที่แตกต่างกันอีกต่อไป เมื่อผู้ใช้แสดงความตั้งใจต่อผู้ช่วย AI ส่วนตัว เช่น “ฉันต้องการซื้อเสื้อผ้าชิ้นใหม่” “สั่งกลับบ้านแบบไหน” หรือ “ค้นหาโอกาสในการลงทุนที่ดีที่สุดในบทความของฉัน” AI ไม่เพียงแต่เข้าใจความต้องการของผู้ใช้เท่านั้น งานทั้งหมดเหล่านี้ยังสามารถดำเนินการได้อย่างมีประสิทธิภาพอีกด้วย โดยจะพบว่าแอปพลิเคชันและผู้ให้บริการที่เกี่ยวข้องมากที่สุดใช้ความตั้งใจของผู้ใช้ในรูปแบบของกระบวนการประมูลที่แข่งขันได้

สิ่งที่สำคัญที่สุดคือ PIN AI ตระหนักถึงความจำเป็นในการนำเสนอบริการแบบกระจายอำนาจที่สามารถให้คุณค่ามากขึ้นภายใต้ภาวะที่กลืนไม่เข้าคายไม่ออกในปัจจุบันที่ผู้ใช้คุ้นเคยกับการโต้ตอบโดยตรงกับผู้ให้บริการแบบรวมศูนย์เพื่อรับบริการ ผู้ช่วย AI ส่วนบุคคลสามารถรับข้อมูลที่มีมูลค่าสูงได้อย่างถูกกฎหมายซึ่งสร้างขึ้นเมื่อผู้ใช้โต้ตอบกับแอปพลิเคชัน Web2 ในนามของผู้ใช้ และจัดเก็บและเรียกใช้ในลักษณะที่มีการกระจายอำนาจ เพื่อให้ข้อมูลเดียวกันสามารถให้คุณค่าที่มากขึ้น ช่วยให้เจ้าของข้อมูล และผู้โทรก็ได้รับประโยชน์เช่นกัน

แม้ว่าเมนเน็ต PIN AI จะยังไม่เปิดตัวอย่างเป็นทางการ แต่ทีมงานได้สาธิตผลิตภัณฑ์ต้นแบบแก่ผู้ใช้ผ่านทาง Telegram ในระดับเล็กน้อยเพื่ออำนวยความสะดวกในการรับรู้วิสัยทัศน์

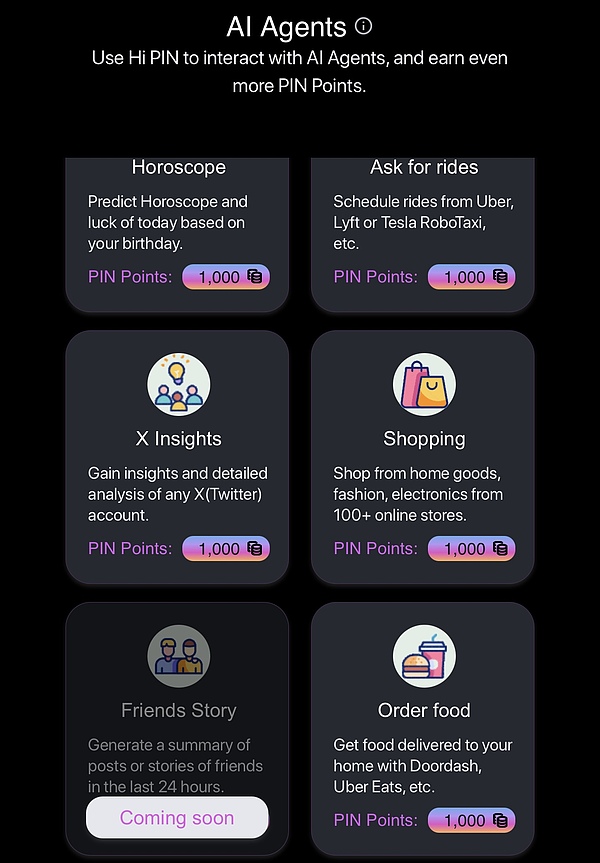

Hi PIN Bot ประกอบด้วยสามส่วน ได้แก่ Play, Data Connectors และ AI Agent

Play คือคู่หูเสมือน AI ที่ขับเคลื่อนโดยโมเดลขนาดใหญ่ เช่น PIN AI-1.5 b, Gemma และ Llama ซึ่งเทียบเท่ากับ ผู้ช่วย AI ส่วนตัว ของ PIN AI

ใน Data Connectors ผู้ใช้สามารถเชื่อมต่อบัญชี Google, Facebook, X และ Telegram เพื่อรับคะแนนเพื่ออัปเกรดสหายเสมือน ในอนาคตจะสนับสนุนผู้ใช้ในการเชื่อมต่อ Amazon, Ebay, Uber และบัญชีอื่น ๆ ซึ่งเทียบเท่ากับ เครือข่ายข้อมูล DePIN ของ PIN AI

ใช้ข้อมูลของคุณเองเพื่อการใช้งานของคุณเอง หลังจากเชื่อมต่อข้อมูลแล้ว ผู้ใช้สามารถส่งต่อข้อกำหนดไปยัง Virtual Companion (เร็วๆ นี้) และ Virtual Companion จะให้ข้อมูลของผู้ใช้แก่ AI Agent ที่ตรงตามข้อกำหนดของงานสำหรับ กำลังประมวลผล.

อย่างเป็นทางการได้พัฒนาต้นแบบ AI Agent บางส่วนซึ่งยังอยู่ในขั้นตอนการทดสอบ ซึ่งเทียบเท่ากับ บริการ AI ภายนอก ของ PIN AI ตัวอย่างเช่น X Insight เข้าสู่บัญชี Twitter และสามารถวิเคราะห์การทำงานของบัญชีได้ เมื่อ Data Connectors รองรับบัญชีอีคอมเมิร์ซ การซื้อกลับบ้าน และแพลตฟอร์มอื่นๆ ตัวแทน AI เช่น การซื้อของและการสั่งอาหาร ยังสามารถมีบทบาทในการประมวลผลคำสั่งซื้อที่ทำโดยผู้ใช้โดยอัตโนมัติ

โดยทั่วไป PIN AI ได้สร้างเครือข่าย AI แบบเปิดผ่านรูปแบบของ DePIN+AI ช่วยให้นักพัฒนาสามารถสร้างแอปพลิเคชัน AI ที่มีประโยชน์อย่างแท้จริง และทำให้ชีวิตของผู้ใช้สะดวกและชาญฉลาดยิ่งขึ้น เมื่อนักพัฒนาเข้าร่วมมากขึ้น PIN AI จะนำแอปพลิเคชันที่เป็นนวัตกรรมมากขึ้นและบูรณาการ AI เข้ากับชีวิตประจำวันอย่างแท้จริง

ซาฮารา: สถาปัตยกรรมหลายชั้นนำไปสู่การตรวจสอบข้อมูล AI ความเป็นส่วนตัว และการทำธุรกรรมที่ยุติธรรม

Sahara เสร็จสิ้นการจัดหาเงินทุน Series A มูลค่า 43 ล้านเหรียญสหรัฐในเดือนสิงหาคมปีนี้ ด้วยการลงทุนจาก VC ที่มีชื่อเสียง เช่น Binance Labs, Pantera Capital และ Polychain

Sahara AI เป็นแพลตฟอร์มแอปพลิเคชันบล็อกเชน AI สถาปัตยกรรมหลายชั้นที่มุ่งเน้นการสร้างแบบจำลองการพัฒนา AI ที่ยุติธรรมและโปร่งใสมากขึ้นในยุค AI ที่สามารถระบุคุณค่าของข้อมูลและกระจายผลกำไรให้กับผู้ใช้ แก้ไขปัญหาความเป็นส่วนตัวและความปลอดภัยในรูปแบบดั้งเดิม ระบบ AI การเก็บข้อมูลและความโปร่งใส

ในแง่ของคนธรรมดา Sahara AI ต้องการสร้างเครือข่าย AI แบบกระจายอำนาจที่ช่วยให้ผู้ใช้สามารถควบคุมข้อมูลของตนเองและรับรางวัลตามคุณภาพของข้อมูลที่พวกเขามีส่วนร่วม ด้วยวิธีนี้ ผู้ใช้จึงไม่ใช่ผู้ให้บริการข้อมูลเชิงรับอีกต่อไป แต่กลายเป็นผู้สร้างระบบนิเวศที่สามารถมีส่วนร่วมและแบ่งปันผลประโยชน์ได้

ผู้ใช้สามารถอัปโหลดข้อมูลไปยัง ตลาดข้อมูลที่มีการกระจายอำนาจ จากนั้นใช้กลไกพิเศษเพื่อพิสูจน์ความเป็นเจ้าของข้อมูล ("การยืนยัน") ข้อมูลนี้สามารถใช้เพื่อฝึก AI และผู้ใช้จะได้รับรางวัลตามคุณภาพของข้อมูล

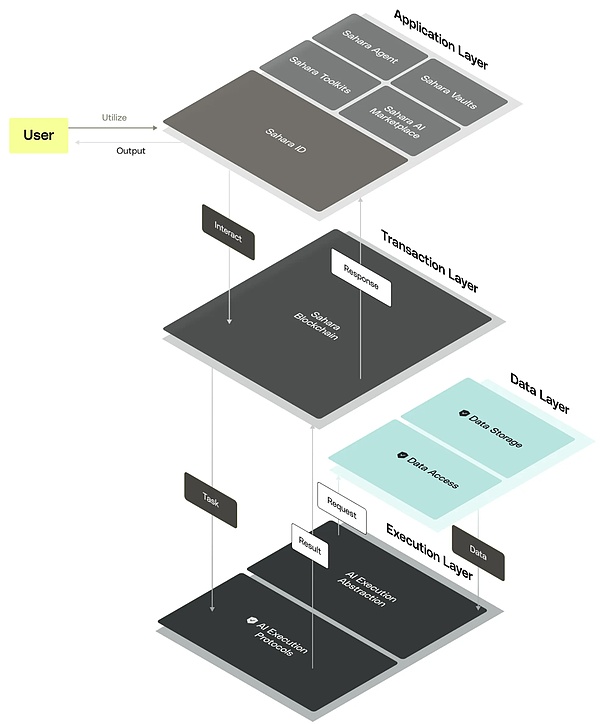

Sahara AI ประกอบด้วยสถาปัตยกรรมแอปพลิเคชัน ธุรกรรม ข้อมูล และการดำเนินการสี่ชั้น ซึ่งเป็นรากฐานที่แข็งแกร่งสำหรับการพัฒนาระบบนิเวศ AI

ชั้นแอปพลิเคชัน : มอบเครื่องมือต่างๆ เช่น ห้องนิรภัยที่ปลอดภัย ตลาดข้อมูล AI แบบกระจายอำนาจ ชุดเครื่องมือที่ไม่มีโค้ด และ Sahara ID เครื่องมือเหล่านี้รับประกันความเป็นส่วนตัวของข้อมูลและส่งเสริมการชดเชยที่ยุติธรรมสำหรับผู้ใช้ ช่วยลดความซับซ้อนของกระบวนการสร้างและปรับใช้แอปพลิเคชัน AI

พูดง่ายๆ ก็คือ ห้องนิรภัยใช้เทคโนโลยีการเข้ารหัสขั้นสูงเพื่อรับรองความปลอดภัยของข้อมูล AI ตลาดข้อมูล AI แบบกระจายอำนาจสามารถใช้สำหรับการรวบรวมข้อมูล คำอธิบายประกอบ และการแปลง ส่งเสริมนวัตกรรมและการค้าที่เป็นธรรม ช่วยให้สามารถพัฒนาแอปพลิเคชัน AI ได้ ง่ายกว่านั้นอีก Sahara ID จัดการชื่อเสียงของผู้ใช้และรับประกันความไว้วางใจ

ชั้นธุรกรรม : บล็อกเชนของ Sahara ใช้กลไกฉันทามติ Proof of Stake (PoS) เพื่อรับรองประสิทธิภาพและความเสถียรของเครือข่าย ช่วยให้สามารถบรรลุฉันทามติได้แม้ในที่ที่มีโหนดที่เป็นอันตราย นอกจากนี้ ฟังก์ชันการคอมไพล์ล่วงหน้าดั้งเดิมของ Sahara ยังได้รับการออกแบบมาเป็นพิเศษเพื่อเพิ่มประสิทธิภาพการประมวลผล AI และสามารถทำการคำนวณที่มีประสิทธิภาพได้โดยตรงในสภาพแวดล้อมบล็อกเชนเพื่อปรับปรุงประสิทธิภาพของระบบ

ชั้นข้อมูล : จัดการข้อมูลทั้งในและนอกเครือข่าย ข้อมูลออนไลน์จะจัดการการดำเนินการที่ไม่สามารถติดตามได้และบันทึกแอตทริบิวต์เพื่อให้มั่นใจในความน่าเชื่อถือและความโปร่งใส ข้อมูลนอกเครือข่ายจะจัดการชุดข้อมูลขนาดใหญ่ และใช้ Merkle Tree และเทคโนโลยีพิสูจน์ความรู้เป็นศูนย์เพื่อรับรองความสมบูรณ์ของข้อมูลและความปลอดภัย เพื่อป้องกันข้อมูลซ้ำซ้อนและการงัดแงะ

เลเยอร์การดำเนินการ : สรุปการทำงานของห้องนิรภัย โมเดล AI และแอปพลิเคชัน AI และสนับสนุนการฝึกอบรม AI การอนุมาน และกระบวนทัศน์การบริการต่างๆ

สถาปัตยกรรมสี่ชั้นทั้งหมดไม่เพียงแต่รับประกันความปลอดภัยและความสามารถในการปรับขนาดของระบบเท่านั้น แต่ยังสะท้อนถึงวิสัยทัศน์ระยะยาวของ Sahara AI ในการส่งเสริมเศรษฐกิจการทำงานร่วมกันและการพัฒนา AI โดยมีเป้าหมายที่จะเปลี่ยนแปลงรูปแบบการประยุกต์ใช้เทคโนโลยี AI อย่างสมบูรณ์ และนำนวัตกรรมและ โซลูชั่นที่ยุติธรรมต่อผู้ใช้

บทสรุป

ด้วยความก้าวหน้าอย่างต่อเนื่องของเทคโนโลยี AI และการเพิ่มขึ้นของตลาดการเข้ารหัส เรากำลังยืนอยู่บนธรณีประตูของยุคใหม่

เนื่องจากโมเดล AI ขนาดใหญ่และแอปพลิเคชันยังคงเกิดขึ้น ความต้องการพลังการประมวลผลก็เพิ่มขึ้นอย่างทวีคูณเช่นกัน อย่างไรก็ตาม การขาดแคลนพลังการประมวลผลและต้นทุนที่เพิ่มขึ้นถือเป็นความท้าทายอย่างมากสำหรับองค์กรขนาดเล็กและขนาดกลางจำนวนมาก โชคดีที่โซลูชันแบบกระจายอำนาจ โดยเฉพาะ Hyperbolic, Aethir และ IO.NET ช่วยให้สตาร์ทอัพด้าน AI มีวิธีใหม่ๆ ในการได้รับพลังการประมวลผล ลดต้นทุน และปรับปรุงประสิทธิภาพ

ขณะเดียวกัน เรายังได้เห็นความสำคัญของข้อมูลในการพัฒนา AI อีกด้วย ข้อมูลไม่เพียงแต่เป็นอาหารของ AI เท่านั้น แต่ยังเป็นกุญแจสำคัญในการส่งเสริมการนำแอปพลิเคชัน AI ไปใช้อีกด้วย โครงการต่างๆ เช่น PIN AI และ Sahara ให้การสนับสนุนข้อมูลที่มีประสิทธิภาพสำหรับการพัฒนา AI โดยการจูงใจเครือข่ายและสนับสนุนให้ผู้ใช้มีส่วนร่วมในการรวบรวมและแบ่งปันข้อมูล

พลังการประมวลผลและข้อมูลไม่ใช่แค่ลิงก์การฝึกอบรม สำหรับแอปพลิเคชัน AI ตั้งแต่การนำเข้าข้อมูลไปจนถึงการอนุมานการผลิต แต่ละลิงก์ต้องใช้เครื่องมือที่แตกต่างกันในการประมวลผลข้อมูลขนาดใหญ่ และนี่เป็นกระบวนการที่ทำซ้ำอย่างต่อเนื่อง

ในโลกที่เชื่อมโยงกันของ AI และ Crypto เรามีเหตุผลที่เชื่อได้ว่าเราจะได้เห็นการดำเนินโครงการ AI ที่เป็นนวัตกรรมมากขึ้นในอนาคต โครงการเหล่านี้ไม่เพียงแต่จะเปลี่ยนงานและไลฟ์สไตล์ของเราเท่านั้น แต่ยังส่งเสริมสังคมทั้งหมดให้มีความชาญฉลาดมากขึ้นอีกด้วย และทิศทางการพัฒนาแบบกระจายอำนาจ ในขณะที่เทคโนโลยีก้าวหน้าอย่างต่อเนื่องและตลาดยังคงเติบโตอย่างต่อเนื่อง เราจึงตั้งตารอคอยการมาถึงของยุค AI ที่เปิดกว้าง ยุติธรรม และมีประสิทธิภาพมากขึ้น