原文作者:Yuxing

本文僅供交流學習,不構成任何投資建議。

ChatGPT 和GPT-4 的火熱,讓我們看到了人工智能的力量。人工智能背後,除了演算法以外,更重要的是海量的數據。圍繞著數據,我們已經建立了一個大規模的複雜系統,該系統的價值主要來自於商業智慧(Business Intelligence, BI)和人工智慧(Artificial Intelligence, AI)。由於網絡時代數據量的快速增長,數據基礎設施的工作和最佳實踐也在快速發展。這兩年,數據基礎設施技術棧的核心系統已經非常穩定,支援工具和應用也快速成長。

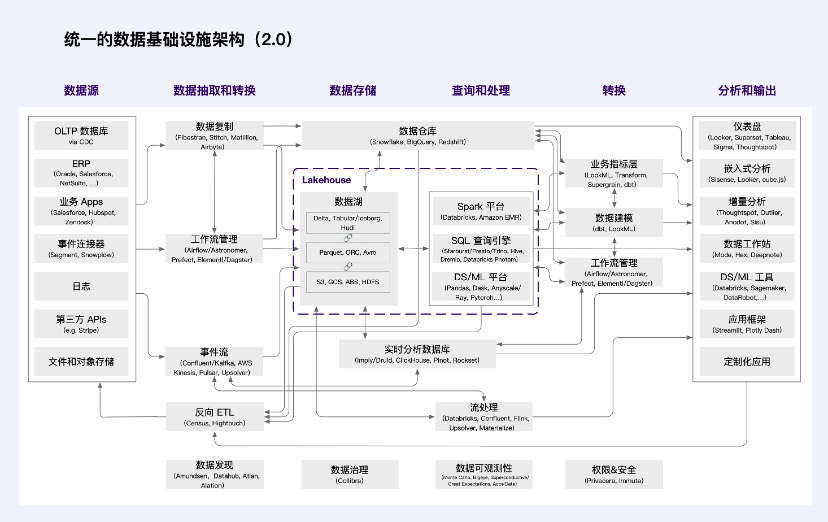

Web2 資料基礎架構架構

雲端資料倉庫(如Snowflake 等)正在迅速成長,主要關注SQL 用戶和商業智慧用戶場景。其他技術的採用也正在加速,資料湖(如Databricks)的客戶成長速度前所未有,資料技術棧中的異質性將共存。

其他核心數據系統,如數據獲取和轉化,已經證明同樣耐久。這在現代數據智能領域尤為明顯。 Fivetran 和dbt(或類似技術)的組合幾乎隨處可見。但在某種程度上,在業務系統中也同樣如此。 Databricks/Spark、Confluent/Kafka 和Astronomer/Airflow 的組合也開始成為事實標準。

來源:a16z

其中,

資料來源端產生相關商務及業務資料;

資料擷取與轉換負責從業務系統中抽取資料(E)、傳輸到儲存、對齊資料來源和目的地之間的格式(L)以及將分析過的資料根據需求送回業務系統;

資料儲存將資料按照可查詢和處理的格式存儲,需要朝向低成本、高可擴展性和分析工作量進行優化;

查詢和處理將高階程式語言(通常用SQL、Python 或是Java/Scala)翻譯成低階資料處理任務。根據儲存數據,使用分散式計算執行查詢和數據模型,包括歷史分析(描述過去發生事件)和預測分析(描述將來期待事件);

轉換將數據轉換成分析可用的結構,管理流程和資源;

分析和輸出是為分析師和資料科學家提供可以溯源洞見和協作的界面,向內部和外部使用者展示資料分析的結果,將資料模型嵌入面向使用者的應用。

隨著數據生態的快速發展,出現了「數據平台」的概念。從產業的角度來看,平台的定義特徵是有影響力的平台提供者和大量的第三方開發者能夠在技術和經濟上相互依賴。從平台的角度來看,數據技術堆疊分為「前端」與「後端」。

「後端」大致包括資料擷取、儲存、處理和轉換,已經開始圍繞小部分雲端服務供應商開始整合。因此,客戶資料被收集在一套標準的系統中,供應商正在大力投資,使其他開發人員可以輕鬆存取這些資料。這也是Databricks 等系統的基本設計原則,並且透過SQL 標準和自訂計算API(例如Snowflake)等系統得到了實現。

“前端”工程師利用這種單點整合來建立一系列新應用程式。他們依賴數據倉庫/湖倉一體中清洗和整合過的數據,而不用擔心它們是如何產生的底層細節。單一客戶可以在一個核心資料系統之上建立和購買很多應用程式。我們甚至開始看到傳統企業系統,如財務或產品分析,正在使用倉庫原生的架構進行重構。

隨著資料技術堆疊的逐漸成熟,資料平台上的資料應用也隨之激增。由於標準化,採用新的數據平台變得前所未有地重要,相應地維護平台也變得極為重要。在規模上,平台可能非常有價值。現在,核心資料系統供應商之間競爭激烈,這種競爭不僅是為了目前的業務,更是為了長期的平台地位。如果你認為資料取得和轉換模組是新興資料平台的核心部分,那麼對資料取得和轉換公司的驚人估值就更容易理解了。

然而,這些技術堆疊的形成是在以大公司為主導的數據利用方式下形成的。隨著社會對數據的理解加深,人們認為數據與土地、勞動力、資本、技術一樣, 都是可市場化配置的生產要素。數據作為五大生產要素之一,背後體現的正是數據的資產價值。

要實現數據要素市場的配置,目前的技術棧遠遠無法滿足需求。與區塊鏈技術緊密結合的Web3 領域,新的資料基礎設施正在發展與演進。這些基礎設施將嵌入現代化數據基礎設施架構,以實現數據產權界定、流通交易、收益分配和要素治理。這四個領域在政府監管的角度來說非常關鍵,因此需要特別注意。

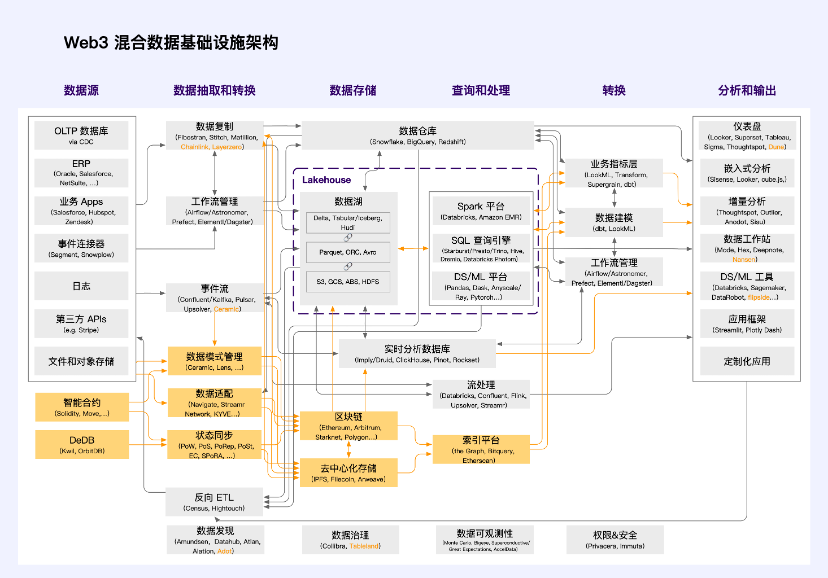

Web3 混合式資料基礎架構架構

受a16z 統一的資料基礎架構架構(2.0 )的啟發,融合對Web3 基礎架構架構的理解,我們提出了以下Web3 混合資料基礎架構架構。

橘色是Web3 獨有的技術堆疊單元。由於去中心化技術仍處於早期發展階段,目前Web3 領域內的大部分應用採用的仍是這種混合資料基礎架構架構。絕大多數應用並不是真正的「 超級結構」。超級結構擁有不可停止、免費、有價值、可擴展、無許可、正外部性和可信中立等特徵。它作為數字世界的公共物品而存在,是“元宇宙”世界的公共基礎設施。這需要完全去中心化的底層架構來支撐它。

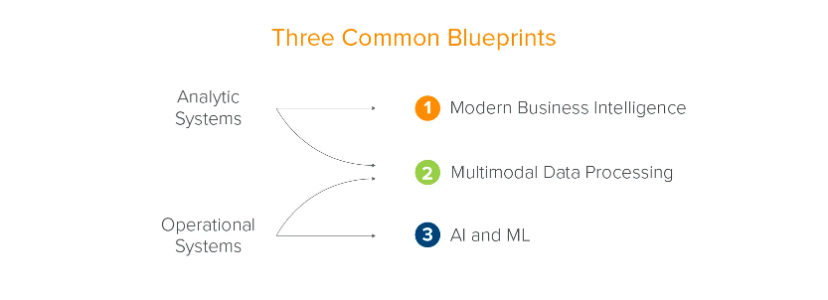

傳統的數據基礎設施架構是根據企業業務發展演變而來的。 a16z 將其總結為兩個系統(分析系統和業務系統)和三個場景(現代商業智慧、多模型資料處理以及人工智慧和機器學習)。這是從企業的角度——數據為企業的發展服務——所做的總結。

來源:a16z

然而,不只是企業,社會和個人都應受益於資料要素帶來的生產力提升。世界各國都接連推出了政策法規,希望從監管的層級規範資料的使用,促進資料的流通。這包括日本常見的各種Data Bank、在中國最近興起的數據交易所以及在歐美已經廣泛使用的交易平台,如BDEX(美國)、Streamr(瑞士)、DAWEX(法國)和CARUSO 等等。

當資料開始進行產權界定、流動交易、收益分配和治理時,它們的系統和場景就不僅僅是賦能企業本身的決策和業務發展。這些系統和場景要麼需要藉助區塊鏈技術,要麼強烈依賴政策監管。

Web3 是資料要素市場的天然土壤,它從技術上杜絕了作弊的可能性,能夠大大減輕監管壓力,讓資料作為真正的生產要素存在,並進行市場化配置。

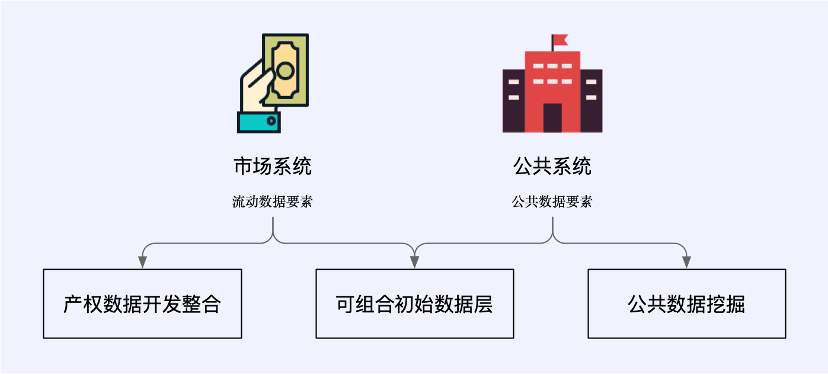

在Web3 情境下,資料利用的新典範包括承載流動資料要素的市場系統和管理公共資料要素的公共系統。它們涵蓋了三個新的資料業務場景:產權資料開發整合、可組合初始資料層和公共資料探勘。

這些場景有的與傳統資料基礎設施緊密結合,屬於Web3 混合資料基礎設施架構;有的則脫離傳統架構,完全由Web3 原生的新技術支援。

Web3 與資料經濟

資料經濟市場是配置資料要素的關鍵,其包括產品資料的開發和整合和具備可組合性的初始資料層市場。在高效率合規的資料經濟市場中, 以下幾點十分重要:

數據產權是保障權益和合規使用的關鍵,應進行結構性分配處置,同時資料使用需確認授權機制。各參與者應擁有相關權益。

流通交易需要場內外結合以及合規高效。應基於資料來源可確認、使用範圍可界定、流通過程可追溯、安全風險可防範四大原則。

收益分配製度需要高效公平。依照「誰投入、誰貢獻、誰受益」的原則,同時政府在資料要素收益分配中能夠發揮引導調節作用。

要素治理安全可控、彈性包容。這需要創新政府資料治理機制,建立資料要素市場信用體系,並鼓勵企業積極參與資料要素市場建設,圍繞資料來源、資料產權、資料品質、資料使用等,推行面向資料商及第三方專業服務機構的資料流通交易聲明和承諾制。

以上原則是監理機關考慮資料經濟的基本原則。在產權資料開發整合、可組合初始資料層和公共資料探勘三種場景下,可以以這些原則為基礎來思考。我們需要怎樣的基礎建設作為支撐?這些基礎設施能夠在哪些階段捕捉什麼樣的價值?

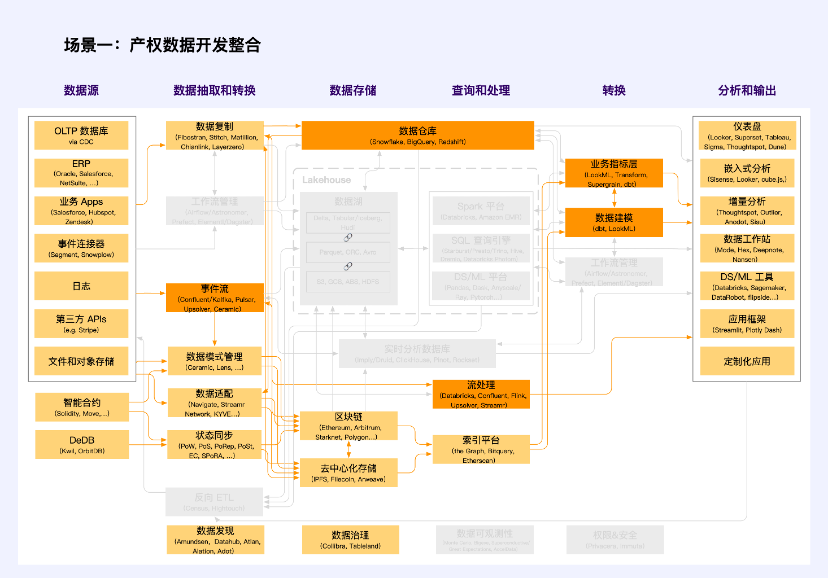

場景一:產權資料開發整合

註:橘色是Web2 與Web3 交叉的單元

在產權資料開發過程中,需要建立分類分級確權授權機制,以確定公共資料、企業資料和個人資料的所有權、使用權和經營權。依據資料來源及產生特徵,以「資料適配」的方式對資料進行產權界定。其中,典型的項目包括Navigate、Streamr Network 和KYVE 等。這些項目透過技術手段實現資料品質標準化、資料收集和介面標準化,將鏈下資料以某種形式確權,並透過智慧合約或內部邏輯系統進行資料分類分級授權。

在該情境下適用的資料類型為非公開資料,即企業資料及個人資料。應以市場化方式“共同使用、共享收益”,從而啟動數據要素價值。

企業資料包括各類市場主體在生產經營活動中採集加工的不涉及個人資訊及公共利益的資料。市場主體享有依法依規持有、使用、獲取收益的權益,以及保障其投入的勞動及其他要素貢獻獲得合理回報的權利。

個人資料要求資料處理者依個人授權範圍依法依法收集、持有、託管和使用資料。運用創新技術手段,推動個人資訊匿名化處理,保障使用個人資訊資料時的資訊安全與個人隱私。探討受託者代表個人利益,監督市場主體對個人資訊資料進行蒐集、加工、使用的機制。涉及國家安全的特殊個人資訊數據,可依法依規授權相關單位使用。

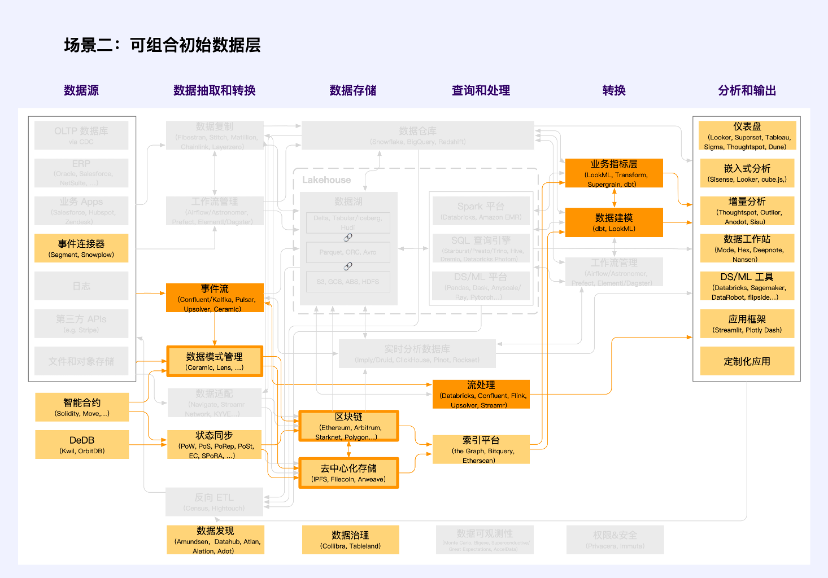

場景二:可組合初始資料層

註:橘色是Web2 與Web3 交叉的單元

可組合初始資料層是資料經濟市場的重要組成部分。與一般的產權資料不同的是,這部分資料最明顯的特徵是需要透過「資料模式管理」定義資料的標準格式。與「資料適配」的品質、擷取和介面標準化不同的是,這裡強調的是資料模式的標準化,包括標準的資料格式和標準的資料模型。 Ceramic 和Lens 是這一領域的先驅,他們分別保障了鏈下(去中心化儲存)和鏈上資料的標準模式,從而使得資料具有可組合性。

搭建在這些資料模式管理工具之上的是可組合初始資料層,通常稱為“data layer”,如Cyberconnect、KNN 3 等。

可組合初始資料層較少涉及Web2 的技術棧,但以Ceramic 為主的熱資料讀取工具打破了這一點,這將是非常關鍵的突破。許多類似的數據無需儲存在區塊鏈上,也很難儲存在區塊鏈上,但它們需要儲存在去中心化的網絡之上,例如用戶的發文、點贊和評論等高頻低價值密度數據,Ceramic 為這一類數據提供了儲存範式。

可組合的初始資料是新時代創新的關鍵場景,也是資料霸權與資料壟斷終結的重要指標。它能夠解決新創企業在數據方面的冷啟動問題,組合成熟數據集和新數據集,從而使新創公司能夠更快地建立數據競爭優勢。同時讓新創企業專注於增量資料價值和資料新鮮度,從而為自身的創新想法贏得持續的競爭力。這樣,大量的數據將不會成為大公司的護城河。

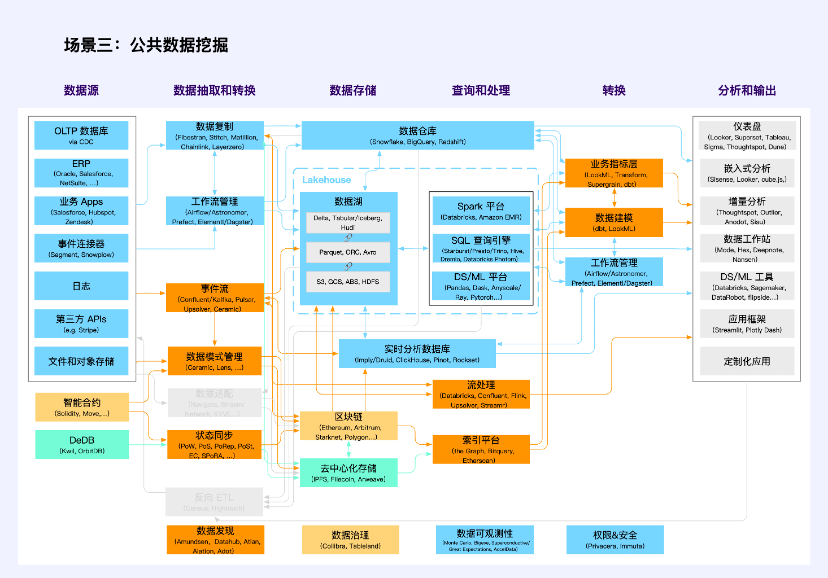

場景三:公共資料探勘

註:橙色是多類別交叉的單元

公共資料探勘並不是一個新的應用場景,但是在Web3 技術堆疊中,它得到了前所未有的突出強調。

傳統的公共資料包括黨政機關、企業單位依法履職或提供公共服務過程中所產生的公共資料。監管機構鼓勵在保護個人隱私和確保公共安全的前提下,按照「原始資料不出域、資料可用不可見」的要求,以模型、核驗等產品和服務等形式向社會提供此類資料。它們採用的是傳統技術棧(藍色和部分橙色,橙色代表多個類型技術棧交叉,下同)。

在Web3 中,區塊鏈上的交易數據以及活動數據是另一類公共數據,其特徵是“可用且可見”,因此缺乏數據隱私、數據安全以及數據使用的確認授權能力,是真正的“公共物品」(Public Goods)。它們採用的是以區塊鍊和智慧合約為核心的技術堆疊(黃色和部分橙色)。

而在去中心化儲存上的數據大多是除交易以外的Web3 應用數據,目前主要以文件和物件儲存為主,相應的技術棧仍不成熟(綠色和部分橙色)。這類公共資料的生產和挖掘利用儲存的普遍問題包括冷熱儲存、索引、狀態同步、權限管理和運算等等。

該場景湧現了許多數據應用,它們不屬於數據基礎設施,更多是數據工具,包括Nansen、Dune、NFTScan、0x Scope 等等。

案例:數據交易所

數據交易所是指以數據為商品進行交易的平台。它們可以根據交易對象、定價機制、品質保證等方面進行分類和比較。 DataStreamX、Dawex、Ocean Protocol 是市場上幾個典型的資料交易所。

Ocean Protocol (2 億市值)是一個開源的協議,旨在讓企業和個人能夠交換和變現資料和基於資料的服務。該協議基於以太坊區塊鏈,使用「數據代幣」(datatokens)來控制對資料集的存取。資料代幣是一種特殊的ERC 20 代幣,可代表一個資料集或一個資料服務的所有權或使用權。用戶可以透過購買或賺取數據通證來獲取所需的資訊。

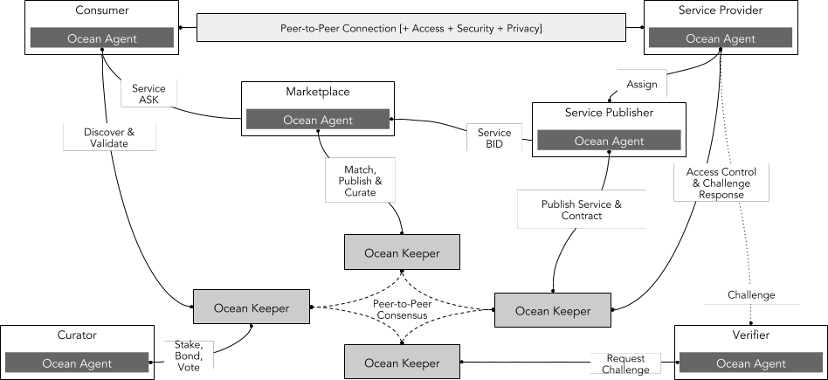

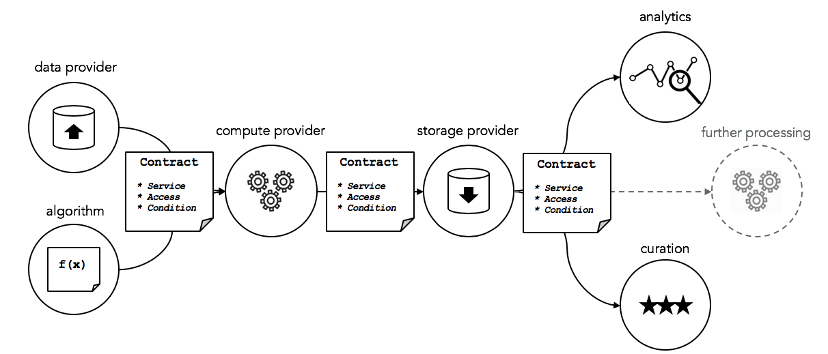

Ocean Protocol 的技術架構主要包括以下幾個部分:

提供者(Providers):指提供資料或資料服務的供應方,可透過Ocean Protocol 發行和出售自己的資料通證,從而獲得收入。

消費者(Consumers):指購買和使用資料或資料服務的需求方,可透過Ocean Protocol 購買或賺取所需的資料通證,從而獲得存取權。

市場(Marketplaces):指由Ocean Protocol 或第三方提供的一個開放、透明和公平的資料交易市場,它可以連接全球範圍內的提供者和消費者,並提供多種類型和領域的資料通證。市場可以幫助組織發現新的商業機會,增加收入來源,優化營運效率,創造更多價值。

網絡(Network):指由Ocean Protocol 提供的一個去中心化的網路層,它可以支援不同類型和規模的資料交換,並確保資料交易過程中的安全、可信賴和透明。網絡層是一組智慧合約,用於註冊資料、記錄所有權資訊、促進安全的資料交換等。

策展人(Curator):指一個生態系統中負責篩選、管理、審核資料集的角色,他們負責審核資料集的來源、內容、格式和許可證等方面的信息,以確保數據集符合標準,並且可以被其他使用者信任和使用。

驗證人(Verifier):指一個生態系統中負責驗證、審核資料交易和資料服務的角色,他們對資料服務提供者和消費者之間的交易進行審核和驗證,以確保資料服務的品質、可用性和準確性。

資料來源:Ocean Protocol

數據提供者創建的「數據服務」包括數據、算法、計算、儲存、分析和策展。這些元件與服務的執行協議(如服務等級協定)、安全計算、存取控制和授權綁定在一起。本質上,這是透過智慧合約來控制一個「雲端服務套件」的存取權限。

資料來源:Ocean Protocol

其優點是,

開源、靈活和可擴展的協定有助於組織和個人創建自己獨特的資料生態系統。

基於區塊鏈技術的去中心化網路層,可以確保資料交易過程中的安全、可信賴和透明,同時也保護了提供者和消費者的隱私和權益。

開放、透明和公平的數據市場,可以連接全球範圍內的提供者和消費者,並提供多種類型和領域的數據通證。

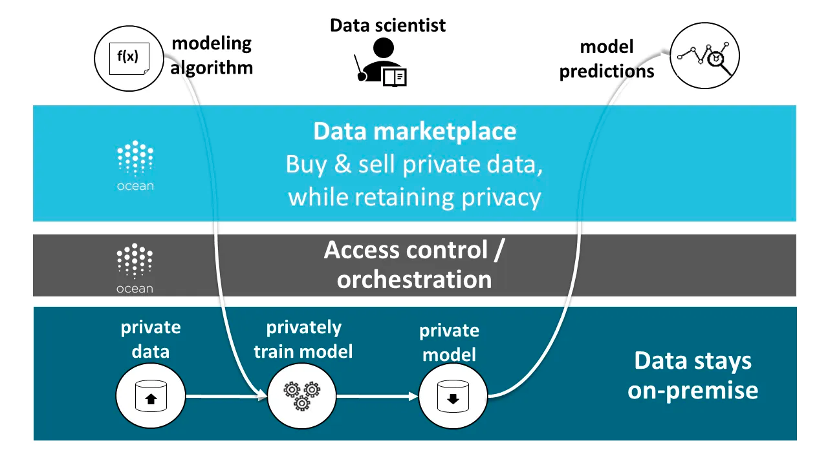

Ocean Protocol 是混合架構的典型代表。其資料可儲存在不同的地方,包括傳統的雲端儲存服務、去中心化的儲存網絡,或資料提供者自己的伺服器。該協議透過資料代幣(datatokens)和資料非同質化代幣(data NFTs)來識別和管理資料的所有權和存取權限。此外,該協定還提供了計算到資料(compute-to-data)的功能,使得資料消費者可以在不暴露原始資料的情況下對資料進行分析和處理。

資料來源:Ocean Protocol

固然Ocean Protocol 是市面上現階段最完善的資料交易平台之一,但它仍面臨許多挑戰:

建立一個有效的信任機制,以增加資料提供者和需求者之間的信任度,降低交易風險。例如,建立資料要素市場信用體系,對資料交易失信行為認定、守信激勵、失信懲戒、信用修復、異議處理等等,透過區塊鏈進行留證與驗證。

建立一個合理的定價機制,以反映數據產品的真實價值,激勵數據提供者提供高品質的數據,並吸引更多的需求者。

建立一個統一的標準規範,以促進不同格式、類型、來源和用途的資料之間的互通性和相容性。

案例:數據模型市場

Ceramic 在其資料宇宙中提到了他們要打造的開放式資料模型市場,因為資料需要互通性,它能夠大幅促進生產力的提升。這樣的資料模式市場是透過對資料模型的緊急共識來實現的,就類似於以太坊中的ERC 合約標準,開發人員可以從中選擇作為功能模板,從而擁有一個符合該資料模型的所有資料的應用程序。目前這個階段,這樣的市場並不是交易市場。

關於資料模型,一個簡單的例子是,在去中心化社交網絡當中,資料模型可以簡化為4 個參數,分別是:

PostList:儲存使用者貼文的索引

Post:儲存單一貼文

Profile:儲存使用者的資料

FollowList:儲存用戶的關注列表

那麼資料模型如何在Ceramic 上建立、共享和重複使用,從而實現跨應用程式資料互通性呢?

Ceramic 提供了一個資料模型登錄(DataModels Registry),這是一個開源的、社群建立的、用於Ceramic 的可重複使用應用程式資料模型的儲存庫。在這裡,開發人員可以在其中公開註冊、發現和重複使用現有資料模型——這是建立在共享資料模型上的客戶操作應用程式的基礎。目前,它基於Github 存儲,未來它將分散在Ceramic 上。

新增到註冊表的所有資料模型都會自動發佈到@datamodels 的npm 插件包下方。任何開發人員都可以使用@datamodels/model-name 安裝一個或多個資料模型,使這些模型可用於在運行時使用任何IDX 客戶端儲存或檢索資料,包括DID DataStore 或Self.ID。

此外,Ceramic 還基於Github 建立了一個DataModels 論壇,資料模型註冊表中的每個模型在該論壇上都有自己的討論線程,社群可以透過它來評論和討論。同時,這裡還可以供開發人員發布關於資料模型的想法,從而在將其添加到註冊表之前徵求社區的意見。目前一切都在早期階段,註冊表中的資料模型並不多,收納進入註冊表中的資料模型應通過社群的評定稱為CIP 標準,就像以太坊的智慧合約標準一樣,這為資料提供了可組合性。

案例:去中心化資料倉庫

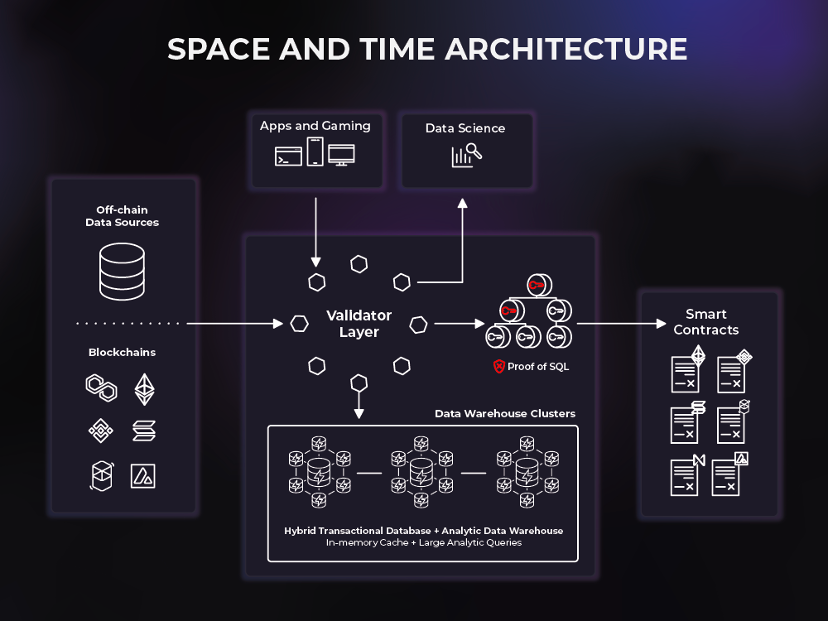

Space and Time 是第一個連接鏈上和鏈下資料以支援新一代智慧合約用例的去中心化資料倉庫。 Space and Time (SxT) 擁有業界最成熟的區塊鏈索引服務,SxT 資料倉儲還採用了一種名為Proof of SQL™ 的新型密碼學來產生可驗證的防篡改結果,允許開發人員以簡單的SQL格式加入無需信任的鏈上和鏈下數據,並將結果直接加載到智慧合約中,以完全防篡改和區塊鏈錨定的方式為亞秒級查詢和企業級分析提供支援。

Space and Time 是兩層網絡,由驗證器層和資料倉庫組成。 SxT 平台的成功取決於驗證器和資料倉庫的無縫交互,以促進對鏈上和鏈下資料的簡單和安全性查詢。

資料倉庫由數據庫網路和運算叢集組成,這些網路由space and time 驗證器控制並路由到它們。 Space and time 採用了非常靈活的倉儲解決方案:HTAP(Hybrid transactional/analytic processing)。

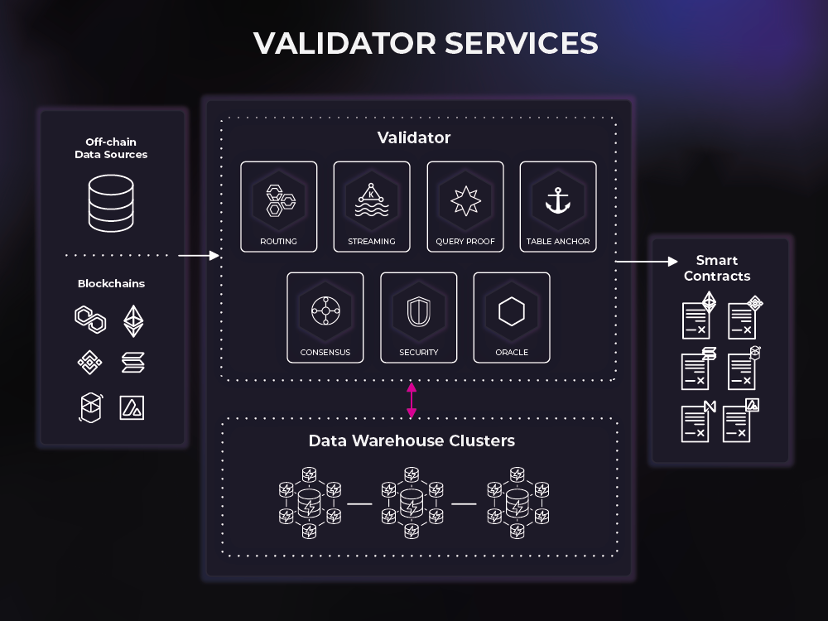

Validator 監視、命令和驗證這些叢集提供的服務,然後編排最終使用者和資料倉庫叢集之間的資料流和查詢。 Validator 為資料進入系統(例如區塊鏈索引)和資料退出系統(例如智慧合約)提供了一種手段。

路由-支援與去中心化資料倉庫網絡的事務和查詢交互

串流媒體-充當大容量客戶串流媒體(事件驅動)工作負載的接收器

共識-對進出平台的資料提供高效率的拜占庭容錯

查詢證明-向平台提供SQL 證明

Table Anchor-透過在鏈上錨定表向平台提供儲存證明

Oracle-支援Web3 交互,包含智慧合約事件監聽和跨鏈訊息傳遞/中繼

安全性-防止未經身分驗證和未經授權存取平台

Space and Time 作為一個平台是世界上第一個分散的資料結構,它開啟了一個強大但服務不足的市場:資料共享。在Space and Time 平台內,公司可以自由共享數據,並且可以使用智慧合約對共享的數據進行交易。此外,資料集可以透過SQL 證明以聚合方式貨幣化,而無需讓消費者存取原始資料。數據消費者可以相信聚合是準確的,而無需看到數據本身,因此數據提供者不再必須是數據消費者。正是出於這個原因,SQL 證明和資料結構架構的結合有可能使資料操作民主化,因為任何人都可以在攝取、轉換和服務資料集方面做出貢獻。

Web3 資料治理與發現

目前,Web3 資料基礎設施架構中缺乏一個實用且有效率的資料治理架構。然而,一個實用且有效率的資料治理基礎設施對於配置各參與方相關權益的資料要素至關重要。

對於資料來源者,需要擁有知情同意和資料本身的自由取得、複製轉移的處置權。

對於資料處理者,需要擁有自主管控、使用資料和獲得收益的權力。

對於資料衍生性商品,需要擁有經營權。

目前Web3 資料治理能力單一,往往只能透過控制私鑰來控制資產與資料(包含Ceramic),分級分類配置能力幾乎沒有。最近,Tableland、FEVM 以及Greenfield 的創新機制,某種程度上可以實現資料的去信任化治理。傳統的資料治理工具如Collibra 一般只能用於企業內部,只具備平台級的信任,同時非去中心化的技術也使得其無法防止個人作惡及單點故障。透過Tableland 等資料治理工具,可以保障資料流通流程所需的安全保障技術、標準與方案。

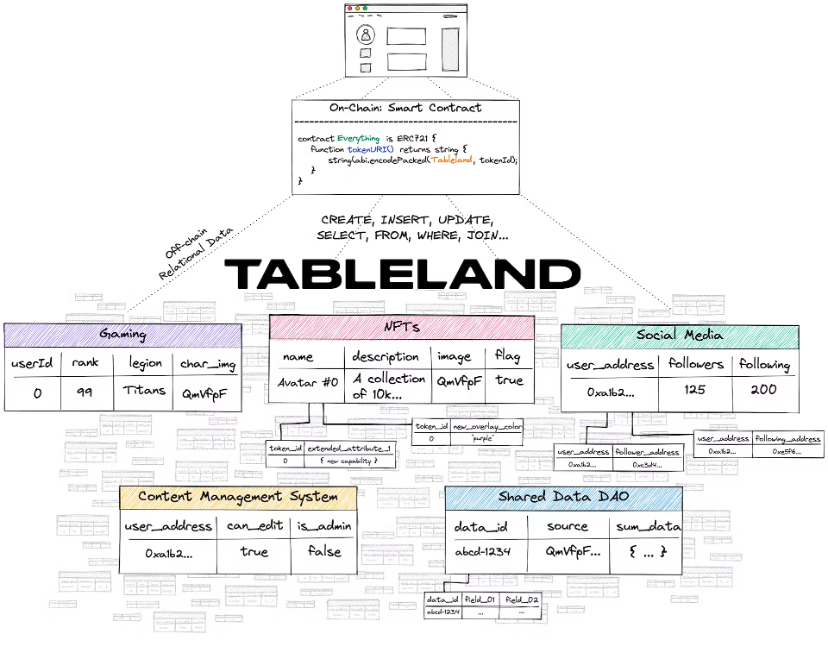

案例:Tableland

Tableland Network 是一種用於結構化關聯式資料的分散式web3 協議,從以太坊(EVM) 和與EVM 相容的L2 開始。借助Tableland,現在可以透過利用區塊鏈層進行存取控制來實現傳統的web2 關聯式資料庫功能。但是,Tableland 並不是一個新的資料庫-它只是web3 原生的關係表。

Tableland 提供了一種新方法,使dapp 能夠將關聯式資料儲存在web3-native 網絡中,而無需進行這些權衡。

解決方案

使用Tableland,元資料可以變更(如果需要,使用存取控制)、查詢(使用熟悉的SQL)和可組合(與Tableland 上的其他表)—所有這些都以完全去中心化的方式進行。

Tableland 將傳統的關聯式資料庫分解為兩個主要元件:具有存取控制邏輯(ACL) 的鏈上註冊表和鏈下(去中心化)表。 Tableland 中的每個表最初都是作為ERC 721 代幣在基本EVM 相容層上鑄造的。因此,鏈上的表格擁有者可以為表格設定ACL 權限,而鏈下Tableland 網絡管理表本身的建立和後續變更。鏈上和鏈下之間的連結都是在合約層級處理的,它只是指向Tableland 網絡(使用baseURI + tokenURI,很像許多使用IPFS 網關或託管伺服器作為元資料的現有ERC 721 代幣)。

只有具有適當鏈上權限的人才能寫入特定表。但是,表格讀取不一定是鏈上操作,可以使用Tableland 網關;因此,讀取查詢是免費的,可以來自簡單的前端請求,甚至可以來自其他非EVM 區塊鏈。現在,為了使用Tableland,必須先建立一個表(即,作為ERC 721 在鏈上鑄造)。部署地址最初設定為表格擁有者,且此擁有者可以為任何其他嘗試與表格互動進行變更的使用者設定權限。例如,所有者可以設定規則,誰可以更新/插入/刪除值,他們可以更改哪些數據,甚至決定他們是否願意轉讓所有權表的另一方。此外,更複雜的查詢可以連接來自多個表(擁有或非擁有)的數據,以建立一個完全動態且可組合的關聯式資料層。

只有具有適當鏈上權限的人才能寫入特定表。但是,表格讀取不一定是鏈上操作,可以使用Tableland 網關;因此,讀取查詢是免費的,可以來自簡單的前端請求,甚至可以來自其他非EVM 區塊鏈。現在,為了使用Tableland,必須先建立一個表(即,作為ERC 721 在鏈上鑄造)。部署地址最初設定為表格擁有者,且此擁有者可以為任何其他嘗試與表格互動進行變更的使用者設定權限。例如,所有者可以設定規則,誰可以更新/插入/刪除值,他們可以更改哪些數據,甚至決定他們是否願意轉讓所有權表的另一方。此外,更複雜的查詢可以連接來自多個表(擁有或非擁有)的數據,以建立一個完全動態且可組合的關聯式資料層。

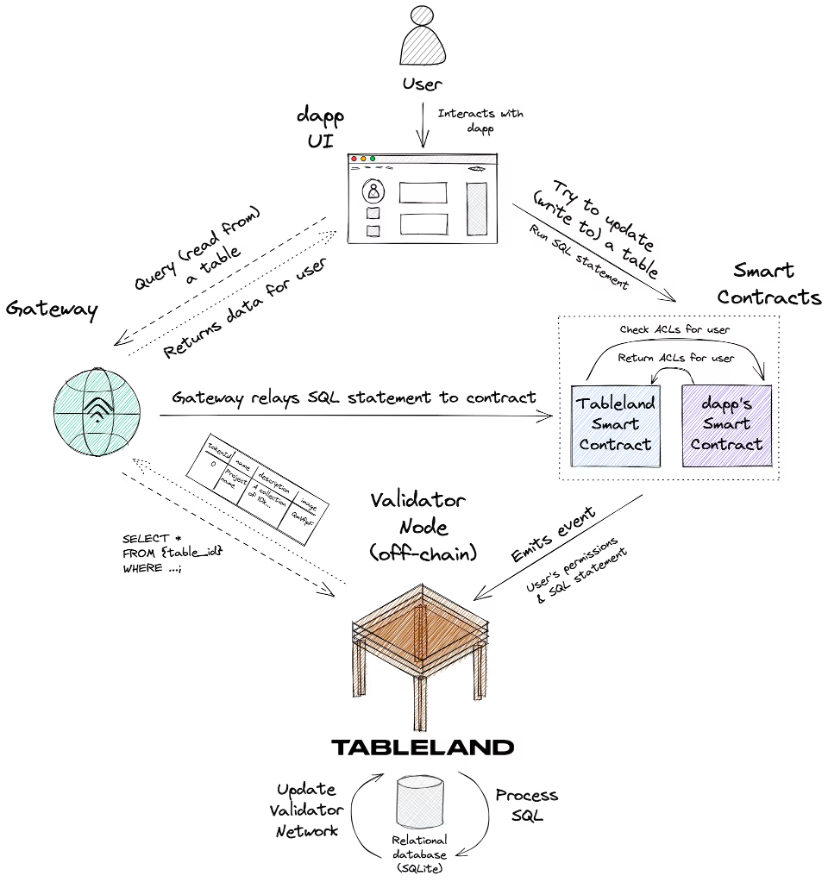

考慮下圖,它概括了新使用者與已由某些dapp 部署到Tableland 的表的交互作用:

以下是整體資訊流:

1. 新使用者與dapp 的UI 互動並嘗試更新儲存在Tableland 表中的一些資訊。

2. dapp 呼叫Tableland 註冊智慧合約來執行這個SQL 語句,而這個合約檢查dapp 的智慧合約,其中包含定義這個新使用者的權限的自訂ACL。有幾點要注意:

dapp 的單獨智慧合約中的自訂ACL 是完全可選但進階的用例;開發人員不需要實施自訂ACL,可以使用Tableland 註冊表智慧合約的預設策略(只有擁有者擁有完全權限) 。

寫入查詢也可以使用網關,而不是直接呼叫Tableland 智慧合約。 dapp 總是存在直接呼叫Tableland 智慧合約的選項,但任何查詢都可以透過網關發送,網關將以補貼的方式將查詢中繼到智慧合約本身。

3. Tableland 智慧合約會取得該使用者的SQL 語句和權限,並將這些合併到發出的事件中,這些事件描述了要採取的基於SQL 的操作。

4. Tableland Validator 節點偵聽這些事件並隨後採取下列操作之一:

如果使用者俱有寫入表的正確權限,驗證器會相應地執行SQL 命令(例如,向表中插入新行或更新現有值)並將確認資料廣播到Tableland 網絡。

如果使用者沒有正確的權限,Validator 不會對錶執行任何操作。

如果請求是簡單的讀取查詢,則傳回對應的資料;Tableland 是一個完全開放的關聯式資料網絡,任何人都可以在其中對任何資料表執行只讀查詢。

5. dapp 將能夠透過網關反映Tableland 網絡上發生的任何更新。

(使用場景)避免什麼

個人識別資料-Tableland 是一個開放的網絡,任何人都可以從任何表格中讀取資料。因此,個人資料不應儲存在Tableland 中。

高頻、亞秒寫入-例如高頻交易機器人。

將每個使用者互動儲存在應用程式中—將這些資料保存在web3 表中可能沒有意義,例如擊鍵或點擊。寫入頻率會導致高成本。

非常大的資料集-應該避免這些,最好透過檔案儲存來處理,使用IPFS、Filecoin 或Arweave 等解決方案。但是,指向這些位置和相關元資料的指標實際上是Tableland 表的一個很好的用例。

關於價值捕獲的思考

不同單元在整個資料基礎設施架構當中都有不可取代的作用,價值其價值擷取主要體現在市值/估值以及預估收益上,可以獲得以下結論:

資料來源是整個架構中價值擷取最大的模組

資料複製、轉換、串流處理和資料倉庫在其次

分析層可能會有很好的現金流,但估值會有上限

簡單的來說,在整個結構圖的左邊的公司/項目,其價值捕獲傾向於更大。

產業集中度

根據不完全的統計分析,產業集中度有以下判斷:

業界集中度最高的是資料儲存以及資料查詢和處理兩個模組

行業集中度中等的是資料擷取與轉換

產業集中度較低的是資料來源、分析和輸出兩個模組

資料來源、分析和輸出產業集中度較低,初步判斷是不同的業務場景導致在每個業務場景中都能夠有垂直場景的龍頭出現,如數據庫領域的Oracle、第三方服務的Stripe、企業服務的Salesforce、儀表板分析的Tableau 以及嵌入式分析的Sisense 等等。

而產業集中度中等的資料擷取與轉換模組,初步判斷原因是因為業務屬性的技術導向。模組化的中間件形式也使得切換成本相對較低。

業界集中度最高的資料儲存以及資料查詢和處理模組,初步判斷是由於業務場景單一、技術含量高、啟動成本高且後續切換具有較大成本,使得公司/專案的先發優勢較強,且具備網絡效應。

資料協定的商業模式和退出路徑

從成立時間上市來看,

在2010 年前成立的大部分是資料來源類公司/項目,行動互聯網還沒興起,資料量還沒有非常大,也有一部分資料儲存和分析輸出類別的項目,儀表板類為主。

2010 年~ 2014 年,是行動互聯網崛起的前夕,誕生了Snowflake 和Databricks 等資料儲存和查詢項目,資料抽取和轉換的項目也開始出現,一套成熟的大數據管理技術方案逐漸完善,期間也出現了大量分析輸出類別的項目,以儀表板類別為主。

2015 年~ 2020 年,查詢和處理類的項目如雨後春筍,同時也有大量數據抽取和轉換的項目不斷出現,讓人們可以更好地發揮出大數據的威力。

2020 年以後,出現了更新的即時分析資料庫和資料湖解決方案,如Clickhouse 和Tabular。

基礎設施的完善是所謂“mass adoption”的前提。在大規模應用期間,也仍然不斷有新的機會,但這些機會幾乎只屬於“中間件”,而底層的數據倉庫、數據源等解決方案幾乎是贏者通吃的局面,除非有技術上實質性的突破,不然都很難成長。

而分析輸出類項目,無論在哪個時期都是創業項目的機會。但也是在不斷迭代創新,基於新的場景做新的事情, 2010 年以前出現的Tableau 佔據了桌面式儀錶盤分析工具的大部分江山,隨後出現的新型場景有如更加專業導向的DS/ML 工具、更全面導向的資料工作站以及更以SaaS 導向的嵌入式分析等等。

從這個視角來看Web3 目前的資料協定:

資料來源與儲存類別專案江山未定,但龍頭初顯,鏈上狀態儲存以以太坊(2,200 億市值)為首,而去中心化儲存以Filecoin(23 億市值)、Arweave(2.8 億市值) 為首,可能會有異軍突起的Greenfield。 ——價值捕獲最高

資料擷取和轉換類別的項目,仍然還有創新空間,資料預言機Chainlink(38 億市值) 只是開始,事件流和流處理基礎設施Ceramic 以及更多的項目會出現,但空間不多。 ——價值捕獲中等

查詢和處理類的項目,the Graph(12 億市值)已經能夠滿足大部分需求,項目類型和數量還沒有到達爆發期。 ——價值捕獲中等

資料分析類的項目,Nansen、Dune(10 億估值)為主,需要有新的場景才有新的機會,NFTScan 和NFTGo 有點類似新的場景,但只是內容更新,而非分析邏輯/範式層面的新需求。 ——價值捕獲一般,現金流可觀。

但Web3 不是Web2 的翻版,也不完全是Web2 的進化。 Web3 有非常原生的使命和場景,從而誕生了和以前完全不一樣業務場景(前面三種場景是目前能夠做出的全部的抽象)。